Este texto de Javier de Felipe apareció originalmente en el número 14 (2013) de la revista CIC Network y lo reproducimos en su integridad por su interés.

La información procedente del mundo que nos rodea es conducida hacia el cerebro a través de un complicado sistema sensorial consistente en receptores de diversas clases que actúan como transductores; estos transforman los estímulos físicos y químicos del ambiente en impulsos nerviosos que el cerebro puede interpretar y darles un significado. Existe una gran variedad de cerebros en el reino animal, pero como además el sistema sensorial es muy distinto entre las diferentes especies, la interpretación, necesariamente, no puede ser la misma; es decir, la interpretación del mundo externo es característica de cada especie.

Asimismo, la inteligencia, creatividad, comunicación y relación entre los seres vivos ha alcanzado su máxima capacidad y refinamiento en el ser humano, y esto se debe, principalmente, al notable desarrollo y evolución del cerebro. Aunque el cerebro funciona de forma modular -en el sentido de que está organizado en bloques o sistemas anatómicos y funcionales (como el sistema visual, el auditivo, etc.)-, estos módulos interactúan entre sí para integrar la información que se procesa por separado. No obstante, el estudio de la corteza cerebral es el tema preferido de muchos científicos teóricos y experimentalistas por su implicación directa en diversos aspectos del comportamiento de los mamíferos y porque es la estructura más ‘humana’ del sistema nervioso del ser humano.

Es decir, la actividad de la corteza cerebral está relacionada con las capacidades que diferencian al ser humano de otros mamíferos, como por ejemplo, el lenguaje, la imaginación y la capacidad de abstracción, permitiéndonos realizar tareas tan extraordinarias y sumamente complicadas y humanas como escribir una poesía o inventar el avión. Sin embargo, el principal obstáculo para estudiar el cerebro es la extrema complejidad de los circuitos neuronales A modo de ejemplo en relación con esta complejidad, se ha calculado que 1 mm3 de corteza cerebral humana contiene en torno a 27.000 neuronas y 1.000 millones de conexiones sinápticas (Alonso-Nanclares et al., 2008). En general, la corteza cerebral contiene un conjunto similar de elementos al de cualquier otra región del sistema nervioso central.

Del mismo modo, las propiedades fisiológicas, los neurotransmisores, receptores y otras moléculas que normalmente se encuentran en las neuronas corticales, no son características exclusivas de la corteza, sino que se encuentran también en diversas regiones del cerebro humano y en el de otras especies. De este modo, dos de las metas principales de la neurociencia son, por un lado, establecer cuál es el substrato neural que hace al hombre ser humano, y por otro, conocer el diseño estructural de los circuitos neuronales y cómo estos contribuyen a la organización funcional del cerebro. La neurociencia ha avanzado de un modo extraordinario en las últimas décadas, permitiendo el estudio del cerebro desde múltiples ángulos -genético, molecular, morfológico y fisiológico-, pero el salto de una disciplina a otra es gigantesco y está poco explorado. Por estos motivos han surgido recientemente ambiciosos proyectos a nivel mundial con objeto de aplicar nuevas tecnologías y aunar esfuerzos para abordar el estudio del cerebro de forma interdisciplinar. A continuación se debate el tema de las maquinas ‘pensantes’ y los proyectos Blue Brain, Cajal Blue Brain y Human Brain Project, como ejemplos de las grandes iniciativas internacionales para investigar el cerebro.

Máquinas ‘pensantes’

A lo largo de los años hemos inventado máquinas cuyas capacidades parecían estar limitadas porque pensábamos que algunas facultades eran exclusivas del ser humano, como por ejemplo, jugar al ajedrez al nivel de un gran maestro. Esto tiene relación con uno de los temas recurrentes desde los tiempos de René Descartes (1596-1650), el de las maquinas pensantes. ¿Podría formular una máquina el célebre principio de Descartes cogito ergo sum (pienso luego existo)? Alan Turing (1912-1954), considerado uno de los padres de la ciencia de la computación y precursor de la informática moderna, comienza su clásico artículo Computing Machinery and Intelligence (Turing, 1950) con el siguiente planteamiento: “Propongo considerar la siguiente cuestión: ¿pueden pensar las máquinas?”. Al final de su ensayo afirma: “Es de suponer que con el tiempo las máquinas podrán competir con los seres humanos en todos los campos puramente intelectuales. ¿Pero por dónde empezar? Incluso esto es una decisión difícil. Muchas personas creen que lo mejor sería comenzar con una actividad muy abstracta, como el juego de ajedrez.” Cuarenta y seis años después, la sugerencia planteada por Turing se hizo realidad, y el superordenador Deep Blue de IBM y el campeón del mundo de ajedrez Gary Kasparov disputaron dos torneos de ajedrez de 6 partidas cada uno.

El primer torneo se jugó en 1996 y Kasparov ganó 3 partidas, empató 2 y perdió una. Al año siguiente, después de que los programadores introdujesen mejoras en el superordenador, se celebró el segundo torneo y Deep Blue ganó 2 partidas, empató 3 y perdió una. Esta victoria de la máquina sobre el ser humano supuso un antes y un después que levantó un gran revuelo en todos los ámbitos académicos: ¿Es Deep Blue una máquina pensante? ¿Significa esta victoria el comienzo de la superioridad de las máquinas y la pérdida del control sobre las máquinas que construimos? ¿Por qué la idea de la inteligencia artificial provoca una reacción emocional negativa en muchos filósofos y neurocientíficos? ¿Dónde está la frontera que delimita el terreno humano y el de la máquina?

La neurociencia computacional está adquiriendo cada vez mayor preponderancia. Parece evidente que para crear un cerebro artificial no es suficiente con replicar cada una de sus partes o sistemas modulares con sus conexiones y organización, sino que es necesario conocer cómo funcionan cada una de estas partes (tareas computacionales) por separado para aprender cómo se generan comportamientos complejos y cómo estos sistemas se integran en una unidad, que es el cerebro. De este modo, se han creado modelos para estudiar cómo se implementan las tareas computacionales a nivel de redes neuronales y cómo estas redes pueden generar comportamientos complejos. Recientemente se ha creado un modelo altamente sofisticado denominado Spaun (acrónimo de Semantic Pointer Architecture Unified Network) que demuestra que diversas tareas, tanto cognitivas como no cognitivas, se pueden integrar en un solo modelo a gran escala (Eliasmith et al., 2012). Spaun está diseñado para responder a secuencias de imágenes visuales (tiene un ‘ojo’ para la entrada de datos) y se comunica con el experimentador a través del movimiento de un modelo físico de ‘brazo’ que escribe sus respuestas (salida). El modelo incluye muchos aspectos de la neuroanatomía, neurofisiología y conducta psicológica, y está basado en la simulación de unos 2,5 millones de neuronas que se organizan en subsistemas que se asemejan a diferentes regiones del cerebro.

Estos subsistemas están conectados mediante un cableado que proporciona la funcionalidad e integración de dichos subsistemas, y se basa en la simulación de las conexiones anatómicas generales de las regiones del cerebro -incluyendo diversas áreas corticales (como la corteza visual, corteza motora primaria y corteza prefrontal) y centros subcorticales, así como diversas regiones de los ganglios basales y el tálamo-. Además, Spaun no solamente integra percepción, cognición y acción a través de varias tareas diferentes, sino que también puede cambiar de tarea y responder sin necesidad de que el experimentador modifique manualmente los parámetros.

Un aspecto interesante es que la arquitectura anatómica y funcional que utiliza Spaun y otros modelos similares está basada en el cableado general entre regiones del cerebro tratadas a modo de ‘cajas negras’ (por ejemplo, el tálamo [caja A] conecta con la corteza visual [caja B]; o un área cortical X está más conectada con un área Z que el área Y). Es decir, únicamente considerando la relación entre las entradas y las salidas de dichas regiones, prescindiendo total o casi totalmente de su estructura interna. Este tipo de arquitectura se puede denominar black brain architecture (arquitectura cerebral negra), y lo interesante es que, como se ha demostrado, es un modelo excelente para simular ciertas funciones del cerebro que hasta ahora era difícil de creer que pudieran ser realizadas con un ordenador.

Esto nos lleva a la cuestión de hasta qué punto es necesario conocer el más mínimo detalle de la estructura del cerebro para descifrar su funcionamiento. Quizás la contestación más satisfactoria es que depende de la complejidad de la tarea y de la respuesta. Así, la acción de caminar no requiere una corteza cerebral motora, ya que la mayoría de los seres que caminan no tienen corteza cerebral, como por ejemplo las hormigas, pero caminar jugando al futbol sí requiere un cerebro humano. En otras palabras, podemos simular y entender cómo nos movemos con tanta exactitud como para construir un robot que nos imite, pero realizar las múltiples tareas complejas típicas del ser humano requiere otro nivel o niveles de conocimiento. En mi opinión, Deep Blue, Spaun y otros modelos son útiles para estudiar ciertos aspectos del funcionamiento del cerebro, pero hasta que no conozcamos completamente el contenido de estas cajas negras y pasemos de la ‘arquitectura cerebral negra’ a una ‘arquitectura cerebral detallada’, en donde además de conocer todos los elementos que componen el cerebro y el mapa de conexiones sinápticas o sinaptoma podamos distinguir la redundancia de los elementos constituyentes, no podremos entender completamente el funcionamiento de cerebro.

Otra característica importante es que el cerebro no puede interaccionar con el medio externo de forma determinista, ya que la información disponible es incompleta y variable. Por el contrario, el cerebro tiene que realizar un cálculo probabilístico del estado del mundo y de los posibles resultados de sus respuestas de forma muy rápida, en cuestión de milisegundos, como por ejemplo reconocer un cambio inesperado del entorno, detectar un peligro y decidir una acción. De este modo, el cerebro se podría definir como un instrumento matemático que utiliza algoritmos sumamente eficaces para interaccionar con el mundo externo y resolver problemas. Si descifráramos dichos algoritmos o trucos matemáticos y el sustrato biológico, ello tendría una aplicación inmediata en las ciencias computacionales, permitiendo la creación de una nueva generación de ordenadores y de programas informáticos basados en el diseño biológico del cerebro. Puesto que cada vez son menores las limitaciones tecnológicas y los científicos estamos mejor organizados para abordar el análisis del cerebro, ¿por qué no podría ser posible construir una corteza cerebral in silico (siliconcortex), es decir, una máquina computarizada basada en un modelo realista del diseño anatómico, fisiológico y molecular del circuito cortical? (de Felipe, 2010). Por estos y otros motivos han surgido a lo largo de los últimos años diversos proyectos a escala mundial, entre los que se incluyen Blue Brain, Cajal Blue Brain y Human Brain Project.

Proyectos Blue Brain, Cajal Blue Brain y Human Brain Project

Los orígenes del proyecto Blue Brain se remontan al año 2005, cuando L’École Polytechnique Fédérale de Lausanne (Suiza) y la compañía IBM anunciaron conjuntamente el ambicioso proyecto de crear un modelo funcional del cerebro utilizando el superordenador Blue Gene, de IBM.

Es importante destacar que este proyecto, dirigido por Henry Markram, tiene por objetivo la ingeniería inversa del cerebro, a fin de explorar su funcionamiento y servir de herramienta para futuras investigaciones en neurociencia y biomedicina. El proyecto no pretende fabricar un cerebro artificial, sino una representación del sistema biológico cerebral, que nada tiene que ver con la creación de inteligencia consciente. A finales de 2006, el proyecto Blue Brain había creado un modelo de la unidad funcional básica del cerebro, la columna cortical (Markram, 2006). Sin embargo, las metas propuestas por el proyecto, que se marca un plazo de 10 años, imponían su conversión en una iniciativa internacional. En este contexto surge en enero de 2009 el proyecto Cajal Blue Brain, donde se materializa la participación española en el proyecto, dirigido por el autor de este artículo en el Laboratorio Cajal de Circuitos Corticales (laboratorio conjunto Universidad Politécnica de Madrid/Consejo Superior de Investigaciones Científicas, localizado en el Centro de Tecnología Biomédica de dicha universidad).

El proyecto Cajal Blue Brain ha permitido disponer de un equipo interdisciplinar de más de 40 investigadores. En términos generales, este proyecto se fundamenta en la idea que sostienen algunos científicos de que para comprender el funcionamiento del cerebro es necesario obtener primero un mapa detallado de las conexiones sinápticas. Esta reconstrucción a gran escala de los circuitos neuronales pronto será posible gracias a los recientes avances tecnológicos para la adquisición y procesamiento de datos experimentales. Aunque la comunidad científica está dividida en lo relativo a la viabilidad y validez de la hipótesis de partida, es importante hacer notar que ya surgieron objeciones similares cuando se propuso por primera vez el proyecto Genoma Humano, que ahora es considerado sin reservas como un logro científico de gran magnitud.

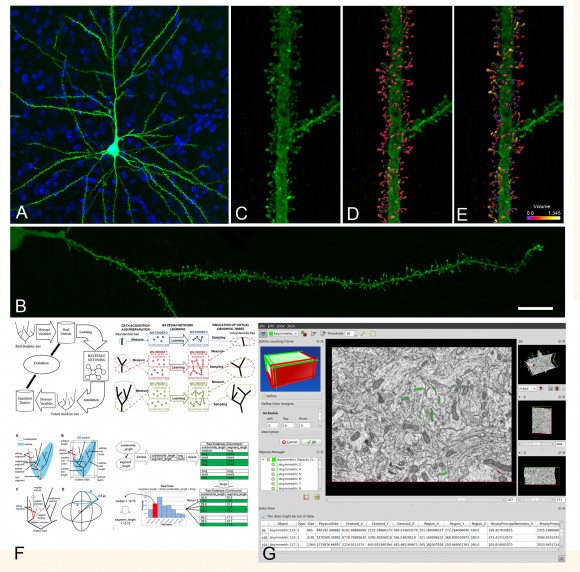

Para el desarrollo del proyecto se cuenta con diversas herramientas y nuevos métodos computacionales que suponen un importante aporte tecnológico. Entre estas herramientas y métodos destacan el desarrollo de técnicas de inyección intracelular e integración y explotación de datos microanatómicos, la utilización del superordenador Magerit (Centro de Supercomputación y Visualización de Madrid, Universidad Politécnica de Madrid) y la nueva tecnología FIB/SEM (microscopio electrónico de doble haz), que permite estudiar a nivel ultraestructural grandes volúmenes de tejido de forma semiautomática, una tecnología esencial para descifrar el sinaptoma (Figura 1).

El proyecto Blue Brain ha servido de base para proponer el proyecto denominado Human Brain Project (HBP; fecha de comienzo, octubre 2013), que es mucho más ambicioso y cuenta con la participación de un número mayor de laboratorios e instituciones de todo el mundo (Markram et al., 2011). El principal objetivo de HBP es obtener simulaciones detalladas, desde el punto de vista biológico, del cerebro humano, así como desarrollar tecnologías de supercomputación, modelización e informáticas para llevar a cabo dicha simulación. Estas simulaciones servirán de base para crear nuevas herramientas para el diagnóstico y tratamiento de enfermedades del cerebro, desarrollo de nuevas prótesis para personas con discapacidad, tecnologías informáticas de baja energía con una capacidad de ‘inteligencia’ similar a la del cerebro con el fin de crear, finalmente, una nueva generación de robots inteligentes.

Los beneficios para la sociedad derivados de HBP serán enormes. Incluso antes de que el proyecto logre sus objetivos finales, los modelos del cerebro de HBP revolucionarán la tecnología de la información, haciendo posible el diseño de ordenadores, robots, sensores y otros dispositivos mucho más eficaces, más inteligentes y de mayor eficiencia energética que los actuales. Aunque el cerebro consume aproximadamente el 20% de la energía de nuestro cuerpo, su eficiencia energética es extraordinaria, ya que gasta más o menos la misma energía que una bombilla de bajo consumo de 20 W (unas 17 kilocalorías/hora), mientras que, por ejemplo, el superordenador Magerit cuya capacidad es equivalente a unos 4.000 ordenadores de sobremesa normales, es de 154 KW (unas 132.446 kilocalorías/ hora). Los modelos del cerebro nos ayudarán a entender las causas de las enfermedades del cerebro en su diagnóstico temprano, cuando todavía se puede tratar. Será más fácil el desarrollo de nuevas curas para las enfermedades del cerebro, reduciendo nuestra dependencia de los ensayos con animales. Dichos modelos nos ayudarán a comprender cómo envejece el cerebro, cómo ralentizar estos cambios y cómo mejorar nuestras capacidades cognitivas y también para alcanzar el máximo de la potencialidad del cerebro de las generaciones futuras. En resumen, los grandes proyectos que ya están en marcha, como el Blue Brain y el liderado por Allen Institute y los que están a punto de comenzar como HBP y Brain Activity Map (Kandel et al., 2013) son ejemplos de cómo las nuevas tecnologías y las estrategias interdisciplinares están dando lugar a avances tecnológicos espectaculares y que sin duda se acelerarán de forma notable con el inicio de las nuevas grandes iniciativas. No cabe duda de que gracias a este nuevo impulso de la neurociencia a escala mundial será posible comprender mejor cómo funciona el cerebro normal y cómo se altera ante diversas enfermedades, con el fin de poder modelar nuevas terapias para el tratamiento de dichas dolencias.

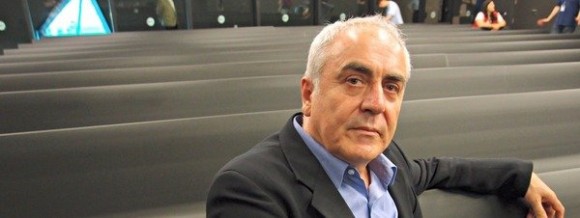

Javier de Felipe (Madrid, 1953), es profesor de investigación en el Instituto Cajal (CSIC), especializado en el estudio micro-anatómico del cerebro; doctor en Biología (Universidad Complutense). Dirige el Proyecto Cajal Blue Brain desde 2009 en el Centro de Tecnología Biomédica de la Universidad Politécnica de Madrid; y es co-director de la división Molecular and Cellular Neuroscience del Human Brain Project. Ha sido nombrado Honorary Member de la American Association of Anatomists.

Edición realizada por César Tomé López a partir de materiales suministrados por CIC Network

“Análisis del cerebro: Innovaci&oa…

[…] Este texto de Javier de Felipe apareció originalmente en el número 14 (2013) de la revista CIC Network y lo reproducimos en su integridad por su interés. La información procedente del mundo que nos rodea es conducida hacia el cerebro a […]

“Análisis del cerebro: Innovaci&oa…

[…] Este texto de Javier de Felipe apareció originalmente en el número 14 (2013) de la revista CIC Network y lo reproducimos en su integridad por su interés. […]