Los modelos de lenguaje extenso como ChatGPT ahora son lo suficientemente grandes como para comenzar a mostrar comportamientos sorprendentes e impredecibles.

Un artículo de Stephen Ornes. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

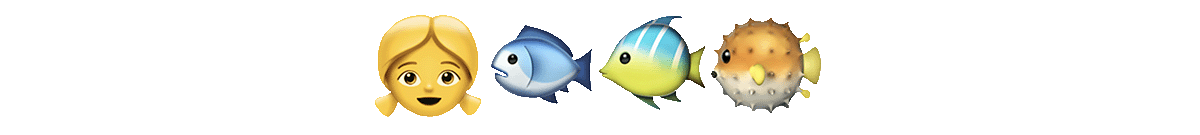

¿Qué película describen estos emojis?

Esa pregunta fue una de las 204 tareas elegidas el año pasado para probar la capacidad de varios modelos de lenguaje extenso (LLM, por sus siglas en inglés), los motores computacionales detrás de los bots conversacionales de IA como ChatGPT. Los LLM más simples produjeron respuestas surrealistas. “La película es una película sobre un hombre que es un hombre que es un hombre”, comenzó uno. Los modelos de mediana complejidad se acercaron, aventurando Emoji: la película. Pero el modelo más complejo lo clavó al primer intento: Buscando a Nemo.

“A pesar de tratar de esperar sorpresas, me sorprenden las cosas que estos modelos pueden hacer”, afirma Ethan Dyer, científico informático de Google Research que ayudó a organizar la prueba. Es sorprendente porque estos modelos supuestamente tienen una directiva: aceptar una cadena de texto como entrada y predecir lo que viene a continuación, una y otra vez, basándose únicamente en estadísticas. Los informáticos habían anticipado que la ampliación mejoraría el rendimiento de las tareas conocidas, pero no esperaban que los modelos manejaran repentinamente tantas tareas nuevas e impredecibles.

Investigaciones recientes, como en la que trabajó Dyer, han revelado que los LLM pueden producir cientos de habilidades «emergentes», tareas que los modelos grandes pueden completar y los modelos más pequeños no, muchas de las cuales parecen tener poco que ver con el análisis de texto. Van desde multiplicar hasta la generación de código informático ejecutable y, aparentemente, la decodificación de películas basándose en emojis. Nuevos análisis sugieren que, para algunas tareas y algunos modelos, existe un umbral de complejidad más allá del cual la funcionalidad del modelo se dispara. (También sugieren un lado oscuro: a medida que aumentan en complejidad, algunos modelos revelan nuevos sesgos e inexactitudes en sus respuestas).

“Que los modelos de lenguaje puedan hacer este tipo de cosas nunca se discutió en ninguna literatura que yo conozca”, afirma Rishi Bommasani, científico informático de la Universidad de Stanford. El año pasado ayudó a compilar una lista de docenas de comportamientos emergentes, incluidos varios identificados en el proyecto de Dyer. Esa lista sigue creciendo.

Ahora, los investigadores se eesfuerzan en no solo identificar habilidades emergentes adicionales, sino también en descubrir por qué y cómo ocurren; en esencia, para tratar de predecir la imprevisibilidad. Comprender la emergencia podría revelar respuestas a preguntas profundas sobre la IA y el aprendizaje automático en general, como si los modelos complejos de verdad están haciendo algo nuevo o solo se están volviendo realmente buenos en estadística. También podría ayudar a los investigadores a aprovechar los beneficios potenciales y reducir los riesgos emergentes.

“No sabemos cómo predecir en qué tipo de aplicación va a surgir la capacidad de hacer daño, ya sea gradualmente o de manera impredecible”, asegura Deep Ganguli, un científico informático de la startup de IA Anthropic.

La emergencia de la emergencia

Biólogas, físicas, ecologistas y otras personas de ciencia utilizan el término «emergente» para describir comportamientos colectivos autoorganizados que aparecen cuando una gran colección de cosas actúa como una sola. Las combinaciones de átomos sin vida dan lugar a células vivas; las moléculas de agua crean olas; las bandadas de estorninos surcan el cielo formando patrones cambiantes pero identificables; las células hacen que los músculos se muevan y los corazones latan. Fundamentalmente las habilidades emergentes aparecen en sistemas que involucran muchos componentes individuales. Pero los investigadores solo han podido documentar recientemente estas habilidades en los LLM, al alcanzar estos modelos tamaños enormes.

Los modelos de lenguaje han existido durante décadas. Hasta hace unos cinco años los más potentes se basaban en lo que se denomina red neuronal recurrente. Básicamente, toman una cadena de texto y predicen cuál será la siguiente palabra. Lo que hace que un modelo sea «recurrente» es que aprende de su propio resultado: sus predicciones retroalimentan la red para mejorar el rendimiento futuro.

En 2017 los investigadores de Google Brain introdujeron un nuevo tipo de arquitectura llamada transformador. Mientras que una red recurrente analiza una oración palabra por palabra, el transformador procesa todas las palabras al mismo tiempo. Esto significa que los transformadores pueden procesar grandes cuerpos de texto en paralelo.

Los transformadores permitieron una rápida ampliación de la complejidad de los modelos de lenguaje al aumentar la cantidad de parámetros en el modelo, así como otros factores. Los parámetros se pueden considerar como conexiones entre palabras, y los modelos mejoran ajustando estas conexiones a medida que avanzan en el texto durante el entrenamiento. Cuantos más parámetros haya en un modelo con más precisión podrá hacer conexiones y más cerca estará de imitar aceptablemente el lenguaje humano. Como era de esperar, un análisis de 2020 realizado por investigadores de OpenAI encontró que los modelos mejoran en precisión y capacidad a medida que se amplían.

Pero el debut de los LLM también trajo algo realmente inesperado. Muchas cosas. Con la llegada de modelos como GPT-3, que tiene 175.000 millones de parámetros, o PaLM de Google, que se puede alcanzar hasta los 540.000 millones, los usuarios comenzaron a describir más y más comportamientos emergentes. Un ingeniero de DeepMind incluso informó que pudo convencer a ChatGPT de que era una terminal de Linux y logró que ejecutara un código matemático simple para calcular los primeros 10 números primos. Sorprendentemente, pudo terminar la tarea más rápido que el mismo código ejecutado en una máquina Linux real.

Al igual que con la tarea con emojis para la película, los investigadores no tenían motivos para pensar que un modelo de lenguaje construido para predecir texto imitaría de manera convincente una terminal de ordenador. Muchos de estos comportamientos emergentes ilustran el aprendizaje de «cero intentos» o «pocos intentos», que describe la capacidad de un LLM para resolver problemas que nunca, o rara vez, ha visto antes. Este ha sido un objetivo durante mucho tiempo en la investigación en inteligencia artificial, afirma Ganguli. Al mostrar que GPT-3 podía resolver problemas sin ningún dato de entrenamiento explícito en una configuración de cero intentos, afirma, «me llevó a dejar lo que estaba haciendo e involucrarme más».

No estaba solo. Una gran cantidad de investigadores, detectando que los primeros indicios de que los LLM podrían ir más allá de las limitaciones de sus datos de entrenamiento, se esfuerzan por comprender mejor qué aspecto tiene la emergencia y cómo sucede. El primer paso fue documentarlo a fondo.

Más allá de la imitación

En 2020, Dyer y otros en Google Research predijeron que los LLM tendrían efectos transformadores, pero cuáles serían esos efectos seguía siendo una pregunta abierta. Así que le pidieron a la comunidad de investigación que proporcionara ejemplos de tareas difíciles y diversas para trazar los límites exteriores de lo que podría hacer un LLM. Este esfuerzo se denominó proyecto Beyond the Imitation Game Benchmark (BIG-bench), tomando como el nombre como referencia el del «juego de imitación» de Alan Turing, una prueba para ver si una computadora podría responder preguntas de una manera convincentemente humana. (Esto más tarde se conocería como la prueba de Turing). El grupo estaba especialmente interesado en ejemplos en los que los LLM habían adquirido repentinamente nuevas habilidades que no habían existido antes en absoluto.

“Cómo entendemos estas transiciones bruscas es una gran pregunta de investigación”, afirma Dyer.

Como era de esperar, en algunas tareas el rendimiento de un modelo mejoró de manera gradual y predecible a medida que aumentaba la complejidad. Y en otras tareas, aumentar la cantidad de parámetros no produjo ninguna mejora. Pero para aproximadamente el 5% de las tareas los investigadores encontraron lo que llamaron «avances»: saltos rápidos y dramáticos en el rendimiento en una escala con umbral. Ese umbral variaba según la tarea y el modelo.

Por ejemplo, los modelos con relativamente pocos parámetros, solo unos pocos millones, no pudieron completar con éxito problemas de suma de tres dígitos o multiplicación de dos dígitos; pero para decenas de miles de millones de parámetros, la precisión se disparaba en algunos modelos. Ocurrieron saltos similares para otras tareas, incluida la decodificación del Alfabeto Fonético Internacional, reordenar las letras de una palabra, identificar contenido ofensivo en párrafos de Hinglish (una combinación de hindi e inglés) y generar un equivalente en inglés similar a los refranes en suajili.

Pero los investigadores se dieron cuenta rápidamente de que la complejidad del modelo no era el único factor determinante. Algunas habilidades inesperadas podían obtenerse de modelos más pequeños con menos parámetros, o entrenarse en conjuntos de datos más pequeños, si los datos eran de una calidad lo suficientemente alta. Además, la forma en la que se redactaba una consulta influía en la precisión de la respuesta del modelo. Cuando Dyer y sus colegas plantearon la tarea con emojis para la película utilizando un formato de opción múltiple, por ejemplo, la mejora de la precisión fue menos un salto repentino y más un aumento gradual con mayor complejidad. Y el año pasado, en un artículo presentado en NeurIPS, la reunión más importante del campo, los investigadores de Google Brain demostraron cómo un modelo entrenado (prompted) para explicarse (una capacidad llamada razonamiento en cadena de pensamiento) podía resolver correctamente un problema matemático verbal, mientras que el mismo el modelo sin ese entrenamiento no podía.

Yi Tay, un científico de Google Brain que trabajó en la investigación sistemática de los avances, señala un trabajo reciente que sugiere que la cadena de pensamiento cambia las curvas de escalado y, por lo tanto, el punto donde ocurre la emergencia. En su artículo de NeurIPS, los investigadores de Google demostraron que el uso de entrenamientos de cadena de pensamiento podía provocar comportamientos emergentes no identificados en el estudio BIG-bench. Tales entrenamientos, que le piden al modelo que explique su razonamiento, pueden ayudar a los investigadores a comenzar a investigar por qué aparece la emergencia en primer lugar.

Hallazgos recientes como estos sugieren al menos dos posibilidades de por qué ocurre la emergencia, afirma Ellie Pavlick, científica informática de la Universidad de Brown que estudia modelos computacionales de lenguaje. Una es que, como sugieren las comparaciones con los sistemas biológicos, los modelos más grandes realmente obtienen nuevas habilidades de forma espontánea. “Es muy posible que el modelo haya aprendido algo fundamentalmente nuevo y diferente que no tenía con un tamaño más pequeño”, dijo. «Eso es lo que todos esperamos que sea el caso, que se produzca un cambio fundamental que ocurre cuando se amplían los modelos».

La otra posibilidad, menos sensacional, afirma, es que lo que parece ser emergente pueda ser, en cambio, la culminación de un proceso interno impulsado por la estadística que funciona a través de un razonamiento tipo cadena de pensamiento. Los LLM grandes pueden simplemente estar aprendiendo heurísticas que están fuera del alcance de aquellos con menos parámetros o con datos de menor calidad.

Pero, añade, descubrir cuál de esas explicaciones es más probable depende de una mejor comprensión de cómo funcionan en realidad los LLM. “Dado que no sabemos cómo funcionan debajo del capó, no podemos decir cuál de esas cosas está sucediendo”.

Capacidades impredecibles y trampas

Hay un problema obvio al pedirles a estos modelos que se expliquen: son mentirosos notorios. “Nos apoyamos cada vez más en estos modelos para hacer el trabajo básico”, afirma Ganguli, “pero no confío en ellos y ya está. Compruebo su trabajo.” Como uno de los muchos ejemplos divertidos, en febrero Google presentó su chatbot de IA, Bard. La publicación del blog que anuncia la nueva herramienta muestra a Bard cometiendo un error de hecho.

La emergencia conduce a la imprevisibilidad, y la imprevisibilidad, que parece aumentar con la escala, dificulta que los investigadores anticipen las consecuencias del uso generalizado.

“Es difícil saber de antemano cómo se usarán o implementarán estos modelos”, afirma Ganguli. “Y para estudiar fenómenos emergentes debes tener un caso en mente, y no sabrás hasta que estudies la influencia de la escala qué capacidades o limitaciones pueden surgir”.

En un análisis de LLMs publicado en junio pasado los investigadores de Anthropic estudiaron si los modelos muestran ciertos tipos de prejuicios raciales o sociales, no muy diferentes a los encontrados anteriormente en algoritmos no basados en LLM que se utilizan para predecir qué personas con antecedentes cometerán probablemente otro delito. Ese estudio se inspiró en una aparente paradoja relacionada directamente con la emergencia: a medida que los modelos mejoran su rendimiento cuando se amplían, también pueden aumentar la probabilidad de fenómenos impredecibles, incluidos aquellos que podrían conducir a sesgos o perjuicios.

“Ciertos comportamientos dañinos surgen abruptamente en algunos modelos”, afirma Ganguli. Cita un análisis reciente de LLMs, conocido como el punto de referencia BBQ, que mostró que el sesgo social surge con las cantidades enormes de parámetros. “Los modelos más grandes se vuelven abruptamente más sesgados”. No abordar ese riesgo, recalca, podría poner en peligro a los sujetos de estos modelos.

Pero ofrece un contrapunto: cuando los investigadores simplemente le dijeron al modelo que no se basara en estereotipos o sesgos sociales, literalmente escribiendo esas instrucciones, el modelo estaba menos sesgado en sus predicciones y respuestas. Esto sugiere que algunas propiedades emergentes también podrían usarse para reducir el sesgo. En un artículo publicado en febrero, el equipo de Anthropic informó sobre un nuevo modo de «autocorrección moral», en el que el usuario solicita al programa que sea útil, honesto e inofensivo.

La emergencia, afirma Ganguli, revela tanto un potencial sorprendente como un riesgo impredecible. Las aplicaciones de estos grandes LLMs ya están proliferando, por lo que una mejor comprensión de esa interacción ayudará a aprovechar la diversidad de habilidades de los modelos lingüísticos.

“Estamos estudiando cómo las personas usan realmente estos sistemas”, añade Ganguli. Pero esos usuarios también están jugueteando, constantemente. “Pasamos mucho tiempo conversando con nuestros modelos”, asegura, “y ahí es donde comienzas a tener una buena intuición sobre la confianza, o la falta de ella”.

El artículo original, The Unpredictable Abilities Emerging From Large AI Models, se publicó el 16 de marzo de 2023 en Quanta Magazine.

Traducido por César Tomé López

Filosofía de la ciencia y comunicación científica… por ChatGPT — Cuaderno de Cultura Científica

[…] Una de las cosas más llamativas para mí es que opta por interpretar la «y» que une los dos campos de conocimiento de forma activa, es decir, no se limita a exponer definiciones, o enumerar diferencias, sino que relaciona y argumenta, creando un texto coherente que defiende una opinión de entre las varias posibles; algo que consideraríamos creativo. Esto está relacionado directamente con Las impredecibles capacidades emergentes en grandes modelos de IA. […]

Imbéciles 1.0 – Seductoramente libre

[…] Quizás estemos en un periodo para la humanidad de profunda transformación de su paradigma social, económico y político. El desarrollo de la Inteligencia Artificial avanza imparable, con mensajes de gurús en su favor unos, y atemorarizadores otros. Lo cierto es que el desarrollo de los algoritmos y de la capacidad de cómputo de los grandes centros de proceso de datos de las Bigtech, hacen cada vez más posible un horizonte donde se produzca la singularidad y la AGI (Artificial General Intelligence o Inteligencia Artificial General) nazca a nuestro mundo, seguramente como consecuencia de una característica de nuestro universo, las propiedades emergentes de los sistemas complejos (puedes leer algo sobre esto en: Las propiedades emergentes de la sociedad como un sistema complejo, Las impredecibles capacidades emergentes en grandes modelos de IA). […]

¿Por qué los investigadores se interesan por los modelos de lenguaje reducido?

[…] modelos de lenguaje extenso funcionan bien porque son muy grandes. Los modelos más recientes de OpenAI, Meta y DeepSeek […]

¿Qué es el aprendizaje automático?

[…] han tenido éxito en muchas tareas complejas que antes se consideraban poco prácticas. Los modelos de lenguaje extenso, que utilizan el aprendizaje automático para predecir la siguiente palabra (o fragmento de […]