Las redes neuronales y otras formas de aprendizaje automático aprenden en última instancia mediante prueba y error, una mejora cada vez.

Un artículo de John Pavlus. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

A estas alturas, muchas personas creen que saben qué es el aprendizaje automático: se “alimentan” los ordenadores con un montón de “datos de entrenamiento” para que “aprendan” a hacer cosas sin que tengamos que especificar exactamente cómo. Pero los ordenadores no son perros, los datos no son chuches y la oración anterior tiene demasiadas comillas. ¿Qué significa realmente todo esto?

El aprendizaje automático es un subcampo de la inteligencia artificial que explora cómo simular (o superar) computacionalmente la inteligencia humana. Si bien algunas técnicas de IA (como los sistemas expertos) utilizan otros enfoques, el aprendizaje automático impulsa la mayor parte del progreso actual en el campo al centrarse en una cosa: usar algoritmos para mejorar automáticamente el rendimiento de otros algoritmos.

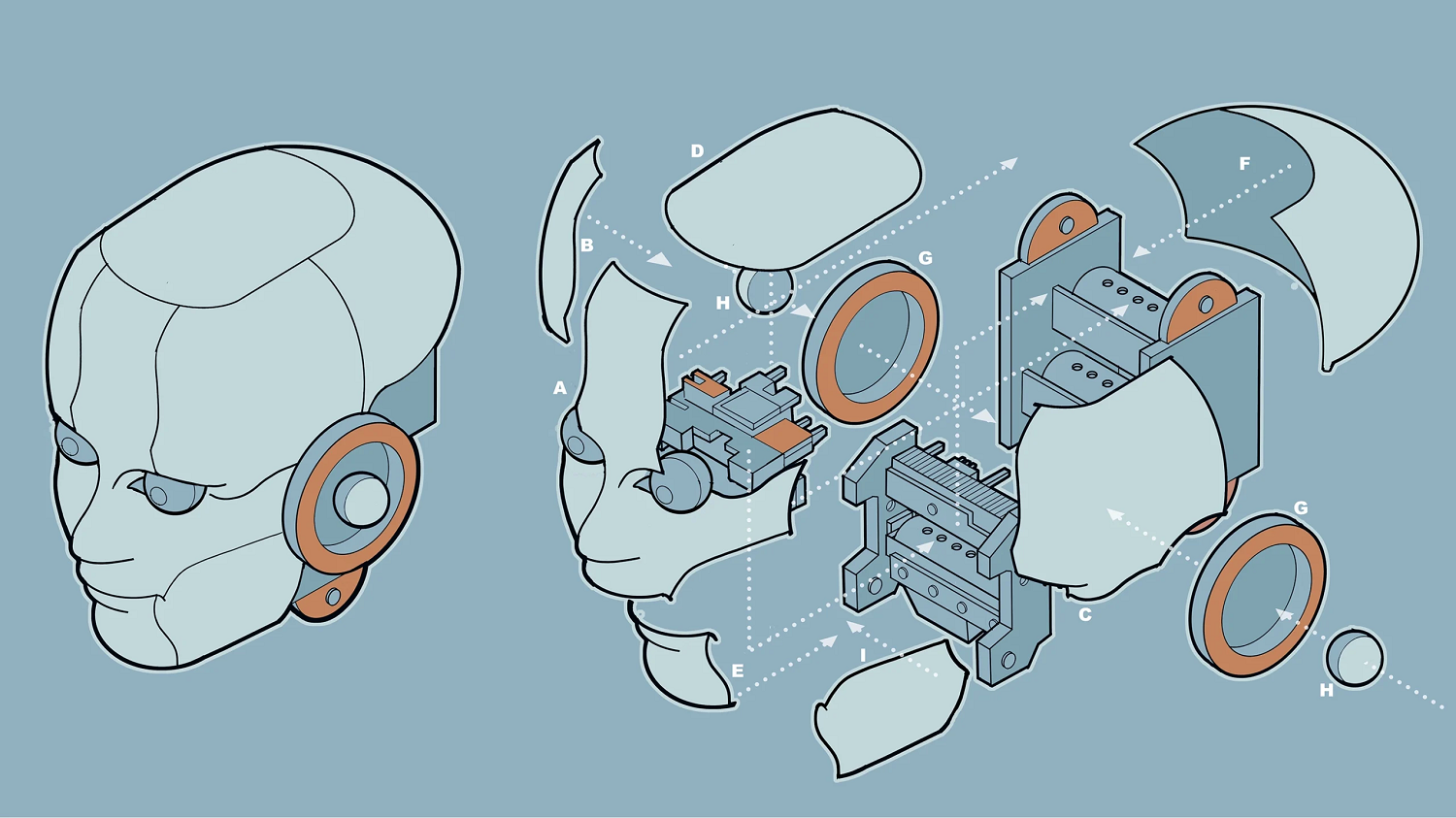

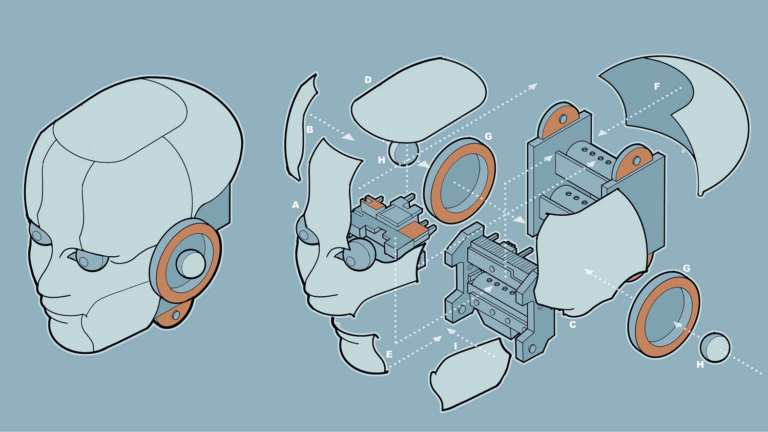

Así es como esto puede funcionar en la práctica, para un tipo común de aprendizaje automático llamado aprendizaje supervisado. El proceso comienza con una tarea, por ejemplo, «reconocer gatos en fotografías». El objetivo es encontrar una función matemática que pueda realizar la tarea. Esta función, llamada modelo, tomará un tipo de números como entrada (en este caso, fotografías digitalizadas) y los transformará en más números como salida, que podrían representar etiquetas que digan «gato» o «no gato». El modelo tiene una expresión matemática básica, o forma, que proporciona cierta estructura para la tarea, pero no es probable que produzca resultados precisos al principio.

Ahora es el momento de entrenar el modelo, que es donde otro tipo de algoritmo toma el relevo. Primero, una función matemática diferente (llamada la objetivo) calcula un número que representa la «distancia» actual entre los resultados del modelo y el resultado deseado. Luego, el algoritmo de entrenamiento utiliza la medición de la distancia al objetivo para ajustar la forma del modelo original. No es necesario “saber” nada sobre lo que representa el modelo; simplemente empuja partes del modelo (llamadas parámetros) en ciertas direcciones matemáticas que minimizan esa distancia entre la salida real y la deseada.

Una vez realizados estos ajustes, el proceso se reinicia. El modelo actualizado transforma las entradas de los ejemplos de entrenamiento en resultados (ligeramente mejores), luego la función objetivo indica otro ajuste (ligeramente mejor) del modelo. Y así sucesivamente, adelante y atrás, adelante y atrás. Después de suficientes iteraciones, el modelo entrenado debería poder producir resultados precisos para la mayoría de sus ejemplos de entrenamiento. Y aquí está el verdadero truco: también debe mantener ese desempeño en nuevos ejemplos de la tarea, siempre y cuando no sean muy diferentes de los de entrenamiento.

Usar una función para modificar repetidamente otra función puede parecer más un trabajo intenso que un “aprendizaje automático”. Pero ese es todo el quid de la cuestión. Poner en marcha este proceso mecánico permite que surja automáticamente una aproximación matemática de la tarea, sin que los seres humanos tengan que especificar qué detalles importan. Con algoritmos eficientes, funciones bien elegidas y suficientes ejemplos, el aprendizaje automático puede crear potentes modelos computacionales que hacen cosas que no tenemos idea de cómo programar.

Las tareas de clasificación y predicción, como identificar gatos en fotografías o spam en correos electrónicos, generalmente dependen del aprendizaje automático supervisado, lo que significa que los datos de entrenamiento ya están ordenados de antemano: las fotos que contienen gatos, por ejemplo, están etiquetadas como «gato». El proceso de entrenamiento da forma a una función que puede asignar la mayor cantidad posible de entradas a sus salidas (conocidas) correspondientes. Después de eso, el modelo entrenado etiqueta ejemplos desconocidos.

Mientras tanto, el aprendizaje no supervisado encuentra estructura dentro de ejemplos sin etiquetar, agrupándolos en grupos que no están especificados de antemano. Los sistemas de recomendación de contenido que aprenden del comportamiento pasado de un usuario, así como algunas tareas de reconocimiento de objetos en visión por ordenador, pueden depender del aprendizaje no supervisado. Algunas tareas, como el modelado del lenguaje realizado por sistemas como GPT-4, utilizan combinaciones inteligentes de técnicas supervisadas y no supervisadas conocidas como aprendizajes auto- y semi-supervisado.

Finalmente, el aprendizaje por refuerzo da forma a una función mediante el uso de una señal de recompensa en lugar de ejemplos de resultados deseados. Al maximizar esta recompensa mediante prueba y error, un modelo puede mejorar su desempeño en tareas dinámicas y secuenciales como jugar juegos (como ajedrez y Go) o controlar el comportamiento de agentes reales y virtuales (como los coches sin conductor o los bots conversacionales).

Para poner estos enfoques en práctica, los investigadores utilizan una variedad de algoritmos que suenan exóticos, desde máquinas kernel hasta Q-learning. Pero desde la década de 2010, las redes neuronales artificiales han pasado a ocupar un lugar central. Estos algoritmos, llamados así porque su forma básica está inspirada en las conexiones entre las células cerebrales, han tenido éxito en muchas tareas complejas que antes se consideraban poco prácticas. Los modelos de lenguaje extenso, que utilizan el aprendizaje automático para predecir la siguiente palabra (o fragmento de palabra) en una cadena de texto, se construyen con redes neuronales «profundas» con miles de millones o incluso billones de parámetros.

Pero incluso estos gigantes, como todos los modelos de aprendizaje automático, son solo funciones en el fondo: formas matemáticas. En el contexto adecuado, pueden ser herramientas extremadamente poderosas, pero también tienen debilidades conocidas. Un modelo «sobreajustado» se ajusta tan perfectamente a sus ejemplos de entrenamiento que no puede generalizar de manera fiable, como un sistema de reconocimiento de gatos que falla cuando se pone una foto al revés. Los sesgos en los datos pueden verse amplificados por el proceso de capacitación, lo que lleva a resultados distorsionados, o incluso injustos. E incluso cuando un modelo funciona, no siempre está claro por qué. (Los algoritmos de aprendizaje profundo están particularmente afectados por este problema de «interpretabilidad».)

Aún así, el proceso en sí es fácil de reconocer. En el fondo, todas estas máquinas aprenden de la misma manera: adelante y atrás, adelante y atrás.

El artículo original, What Is Machine Learning?, se publicó el 8 de julio de 2024 en Quanta Magazine.

Traducido por César Tomé López

Alzhéimer, detección precoz con inteligencia artificial

[…] Universidad Politécnica de Madrid (UPM) han aplicado técnicas de inteligencia artificial (IA) de aprendizaje automático al análisis de diferentes modalidades de imágenes médicas utilizadas para el diagnóstico de […]

La interpretabilidad de los modelos de inteligencia artificial

[…] ¿verdad? Este escenario puede sonar a ciencia ficción, pero es un reto real en el mundo del aprendizaje automático hoy en […]

Aprendizaje por refuerzo basado en modelos de máxima entropía

[…] ciencias de la computación e inteligencia artificial, el aprendizaje automático por refuerzo es un conjunto de metodologías que tiene por objetivo la formulación de secuencias […]