Computadores analógicos, digitales, clásicos y cuánticos

La digitalización masiva es un error irreflexivo y anticientífico, que nos puede arrastrar a la virtualidad, no a la realidad. En ciencia observamos la naturaleza real, realizamos experimentos reales, establecemos teorías que explican dichas observaciones y que prevén otros resultados no observados, los cuales podremos verificar (o no) con otros experimentos reales. Además, cuando desconocemos los fundamentos científicos profundos de sistemas complejos nos servimos de útiles métodos computacionales para tratar de simular la realidad de la mejor manera posible.

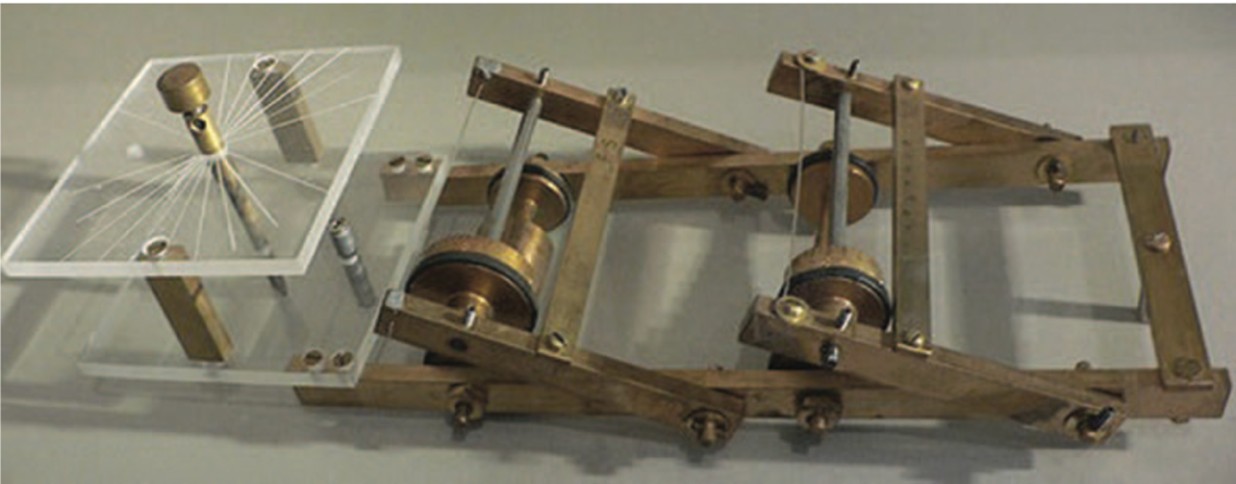

Desde la antigüedad se han construido dispositivos que usan fenómenos mecánicos, eléctricos o hidráulicos para simular análogamente la realidad. Estos son los computadores analógicos, como por ejemplo el antiguo mecanismo de Anticitera, el Analizador Diferencial, o el FERMIAC [1].

Electrónica analógica y digital

Aunque los computadores analógicos tienen milenios de antigüedad, éstos experimentaron un avance generalizado en el siglo XX, primero con el descubrimiento del electrón, que condujo a la construcción de diodos y triodos mediante tubos de vacío, y después con la aparición de la electrónica de estado sólido, que permitió construir diodos, transistores y amplificadores operacionales capaces de procesar información analógica en paralelo.

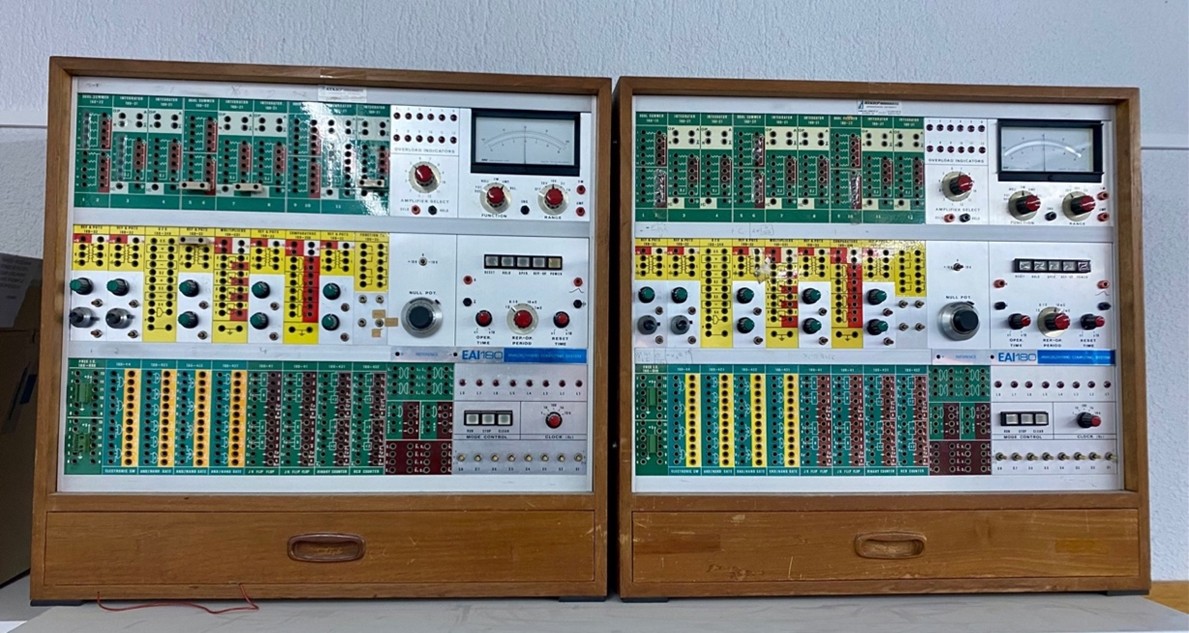

Respecto a los computadores digitales, hacia el final de la década de 1960 éstos solo eran accesibles para grandes compañías o gobiernos. Sin embargo, pequeños laboratorios de humildes universidades como la Universidad de Bilbao fundada en 1968, podían disponer de computadores analógicos, capaces de realizar complejos cálculos y simulaciones de propósito general, de enorme utilidad para cualquier rama de la ciencia.

Los computadores analógicos pueden procesar información continua mediante lógica no determinista y en tiempo real. Por ello, realizar funciones complejas, no lineales, continuas y en paralelo con sistemas analógicos es mucho más fácil que con sistemas digitales. Sin embargo, al no trabajar con valores binarios 1 y 0, también pueden producir ruido más fácilmente que los computadores digitales. Este hecho, junto con el abaratamiento de los chips microprocesadores digitales parecieron hacer desaparecer la utilidad de la computación analógica.

Precisión, velocidad y tolerancia a errores

La distinción entre computadores analógicos y digitales no radica exclusivamente en sus mecanismos de procesamiento de información, sino también en la eficiencia, precisión y tolerancia a errores que podemos esperar en distintos tipos de cálculo y aplicaciones.

Los computadores digitales dan alta precisión en sus cálculos numéricos, ya que los datos binarios evitan inexactitudes. Esto supera en principio a cualquier computador analógico, ya que las señales analógicas que procesan pueden estar sometidas de inicio a imprecisiones.

Sin embargo, un computador analógico, al estar alimentado por flujo de señal continua, puede funcionar en tiempo real, de manera diferente a un computador digital, que procesa datos numéricos de forma secuencial. Además, un computador analógico es mucho más tolerante a errores: pequeñas variaciones en el flujo de datos de entrada no afectan drásticamente al resultado de la computación. Sin embargo, en un computador digital hay que detectar los datos binarios erróneos y corregirlos: si no, el resultado es inservible.

Computación clásica analógica o digital

Aunque la computación digital es claramente dominante, su empleo para procesar cada vez más cantidad de datos a mayor velocidad da lugar a excesos de gastos de energía y memoria, especialmente en las conocidas aplicaciones IA basadas en reconocimiento de patrones y en la generación estadística partiendo de enormes bases de datos.

Pero procesar gran cantidad de información para el reconocimiento de audio o imágenes es más fácil para los computadores analógicos: se trata de procesar directamente las propiedades físicas de las señales de audio o video. Así, un computador analógico puede realizar estas operaciones de forma más rápida y eficiente que los sistemas digitales, ya que no requiere la conversión de las señales analógicas a datos digitales. Esto hace que los computadores analógicos sean especialmente adecuados para tareas en las que la velocidad y la capacidad de manejar grandes conjuntos de datos en tiempo real sean fundamentales, aunque a costa de la alta precisión y versatilidad que ofrecen los sistemas digitales.

Además, si queremos modelar redes neuronales más realistas que las que hoy se usan en IA, no sólo existen neuronas que funcionan digitalmente, sino que de hecho la neurociencia nos explica que existen muchos más tipos de redes naturales -más bien analógicas- que pueden modelarse mejor con un computador analógico.

El principio de funcionamiento de la mente humana es más analógico que digital. El cerebro toma datos de otros sensores y redes analógicas y los utiliza para realizar sus cálculos, en lugar de acceder a ellos desde una memoria digital. Además, en lugar de un procesador digital de 256 bits, los sistemas analógicos utilizan procesadores analógicos de medida directa para realizar la misma operación. Este sistema analógico es más eficiente y disipa mucha menos energía.

Computación cuántica analógica o digital

Richard P. Feynman cuando estudiaba computación [2] decía que, si la naturaleza no es clásica sino cuántica, para simularla de forma realista, es mejor hacerlo con un computador cuántico.

La cuantización de magnitudes medibles parece sugerir que la realidad es digital, pero esto no lo sabemos. La constante de Planck y todas las asociadas son un sistema de unidades basado en las cantidades fundamentales determinadas por las leyes físicas, pero no hay nada en esto que implique una discretización del universo.

La pregunta más profunda asociada es si la realidad es entonces digital o analógica. La teoría completa de gravitación cuántica sigue siendo un problema no solucionado [3], y hay experimentos propuestos para detectar si el tiempo-espacio es discreto o continuo, digital o analógico [4].

Entre tanto, los computadores cuánticos digitales experimentan serios problemas no solo con la cantidad de qubits que pueden construirse, sino con el mantenimiento de su coherencia cuántica. Estos errores digitales deben detectarse y eliminarse. Perfeccionar los computadores cuánticos digitales requiere mantener la coherencia de los qubits, gestionar las tasas de error y abordar la complejidad del hardware, incluyendo puertas digitales. Por esta razón muchos grupos investigadores explotan las ventajas de la versión analógica de computadores cuánticos, para poder simular de forma realista la naturaleza [5]. Los computadores analógicos no están obsoletos, y dejemos claro que la virtualidad no es la realidad.

Referencias

[1] Fabrizio Coccetti (2016) The Fermiac or Fermi’s Trolley. Il Nuovo Cimento 39 C, 296. doi: 10.1393/ncc/i2016-16296-7

[2] Richard P. Feynman (1982) Simulating physics with computers. Int J Theor Phys 21, 467–488. doi: 10.1007/BF02650179

[3] Jarmo Mäkelä (2011) Is Reality Digital or Analog? arXiv:1106.2541 [physics.pop-ph] https://doi.org/10.48550/arXiv.1106.2541

[4] Todd A. Brun and Leonard Mlodinow (2019) Detecting discrete spacetime via matter interferometry. Phys. Rev. D 99, 015012. doi: 10.1103/PhysRevD.99.015012

[5] Daniel González-Cuadra, Majd Hamdan, Torsten V. Zache et al. (2025) Observation of string breaking on a (2+1)D Rydberg quantum simulator. Nature 642, 321–326. doi: 10.1038/s41586-025-09051-6

Sobre el autor: Victor Etxebarria Ecenarro es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (EHU)