La crisis de reproducibilidad en ciencia

Uno de los elementos más valiosos con que debiera contar la comunidad científica es con la replicación sistemática de los estudios o, al menos, con aquellos que introducen alguna novedad significativa. Sin embargo, la mayoría de los científicos se muestran poco inclinados a tratar de replicar los experimentos o análisis realizados por otros investigadores. Al fin y al cabo, resulta mucho más gratificante hacer nuevos estudios que puedan aportar novedades de interés en un campo que limitarse a comprobar si se obtienen los mismos resultados que obtuvieron antes otros. Además, las revistas científicas no están interesadas en publicar repeticiones, máxime si las conclusiones no refutan las del primer trabajo; en ese caso no hay novedades que contar.

En varios estudios se ha llegado a la conclusión de que muchos resultados publicados no son reproducibles o solo lo son parcialmente. Aunque lleva años generando preocupación, este problema se manifestó con toda su crudeza a raíz de la publicación en 2015 de un estudio en la revista Science, según el cual tan solo para una treintena de 100 experimentos de psicología publicados en las mejores revistas científicas del campo se habían podido reproducir sus resultados. Pero el problema no se limita a la psicología, sino que afecta a un buen número de disciplinas.

De acuerdo con una encuesta realizada en 2016 por la revista Nature a 1500 investigadores de diferentes campos, el 70% habían sido incapaces de reproducir los resultados de otros colegas y el 50% no lo habían sido de reproducir sus propios resultados. Por disciplinas, estos fueron los datos de la encuesta: en química el 90% y el 60% (ajenos y propios, respectivamente), en biología el 80% y el 60%, en medicina el 70% y el 60%, en física e ingeniería el 70% y el 50%,en medicina, y en ciencias de la Tierra y el ambiente el 60% y el 40% (Baker, 2016).

Parece evidente que la imposibilidad o dificultad para reproducir resultados constituye una severa limitación al ejercicio del escepticismo, sin el cual no es posible someter a contraste los resultados y conclusiones publicadas.

Aunque a veces la imposibilidad de reproducir los resultados se refiere a casos de fraude, lo normal es que no haya trampa ni malas prácticas realizadas de forma voluntaria. Las razones por las que los resultados experimentales no se reproducen al repetirse los experimentos son diversas. Muchas veces no se especifican de forma correcta las condiciones experimentales. En otras los investigadores se ven afectados por sesgos como los expuestos en una anotación anterior y que tienen que ver con el grado de aproximación de los resultados obtenidos a las expectativas iniciales. Cuando en un conjunto de datos alguno destaca como “anómalo” es relativamente común descartarlo basándose en el supuesto de que la anomalía bien puede deberse a un error experimental sin trascendencia. En todo esto influyen de forma decisiva dos factores. Uno es que el personal de universidades y centros de investigación, como ya hemos visto, está sometido a una fuerte presión por publicar. Y el otro es que las revistas científicas rara vez aceptan publicar resultados negativos. Por esa razón, no es de extrañar que funcionen sesgos que, inconscientemente, facilitan la obtención de resultados positivos y, por lo tanto, publicables.

El tratamiento estadístico es también una fuente de resultados de difícil reproducción. Es relativamente común la práctica de ensayar diferentes procedimientos y seleccionar, entre un catálogo más o menos amplio de posibilidades, aquél cuyos resultados mejor se acomodan a las expectativas. Este es un problema serio en los campos en que se realizan ensayos que han de conducir al desarrollo posterior de tratamientos médicos. Pero, el daño que causa es general, ya que esa forma de proceder tiende a neutralizar la emergencia de nuevas ideas que debería caracterizar, de forma intrínseca, a la práctica científica. Si se opta por mostrar los resultados que mejor se acomodan a las expectativas, se deja de lado el examen crítico de posibilidades que podrían haber conducido a nuevas ideas.

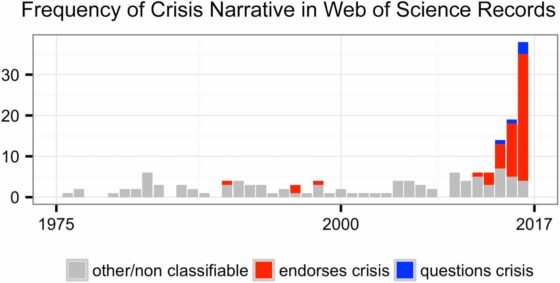

La revista Proceedings of the National Academy of Sciences, más conocida por sus siglas PNAS y una de las más prestigiosas del mundo, publicó una serie de artículos analizando la llamada “crisis de reproducibilidad” y, en general, la validez de un discurso muy en boga mediante el que se difunde la idea de que la ciencia se encuentra hoy en crisis. De ese conjunto de estudios parece concluirse que esa idea no tiene suficiente base y que se trata, más bien, de una leyenda urbana. Sin embargo, en nuestra opinión, lo que esos estudios documentan es que el fraude no ha crecido durante las últimas décadas, de la misma forma que no ha crecido el número de artículos retractados (retirados de la publicación por los editores) en términos relativos. Pero no es tan clara la conclusión de que no hay problemas de reproducibilidad, porque el procedimiento seguido para llegar a esa conclusión es demasiado indirecto, mientras que los estudios que documentan las dificultades para reproducir resultados anteriores son bastante más directos.

En nuestra opinión, la falta de reproducibilidad procede de una progresiva relajación de los estándares que se consideran aceptables en cuanto calidad de la evidencia científica; nos referimos a asuntos tales como tamaños de muestra, claridad de la significación estadística más allá del valor de p, calidad de los blancos, etc. Los científicos como colectivo somos a la vez autores de los experimentos, autores de los artículos y revisores de estos. Que poco a poco se vayan aceptando niveles cada vez más bajos nos conviene si nuestro objetivo es el de publicar más rápidamente y engrosar un currículo investigador en un tiempo breve. Pero eso conduce, lógicamente, a un declive del rigor y exigencia generales. Ahora bien, al tratarse de un declive gradual, no se aprecia con nitidez la pérdida de calidad. Sin embargo, cuando el deterioro se acentúa se acaban dando por buenos (publicándolos) resultados que realmente no responden a hechos reales y por tanto no se pueden reproducir.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

Noticia Nº66: Revisión por pares y Open Access, ¿necesarios o un costoso lastre para la Ciencia?. – Noticias de un Espía en el Laboratorio

[…] que nunca fueron publicados por sus autores. Otro problema asociado a la revisión por pares es la crisis de reproducibilidad. Aproximadamente el 70% de los artículos científicos publicados no han podido ser reproducidos. […]