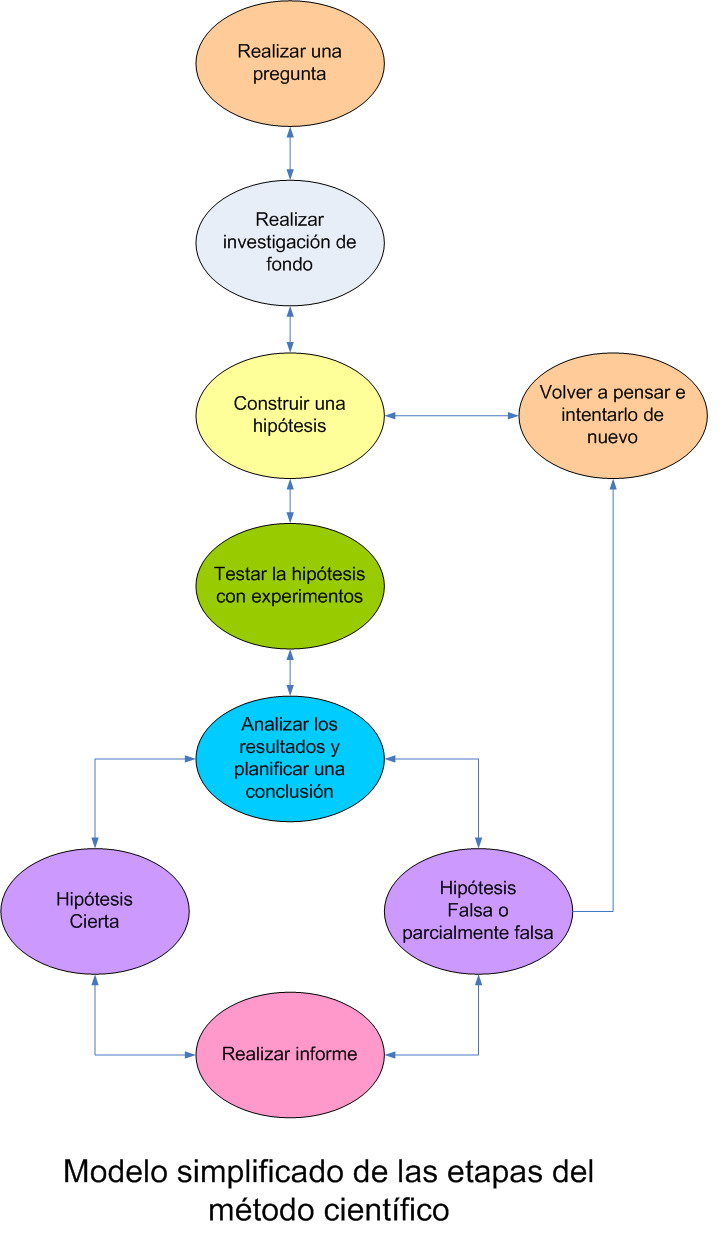

Cuando pensamos en el método científico solemos tener en mente algo parecido al esquema que abre esta anotación. Sin embargo, a la hora de la verdad, con tantos científicos trabajando en el mundo, con, literalmente, miles de journals en circulación, es relativamente frecuente encontrarse con que hay gente sin escrúpulos capaz de saltarse uno (e incluso varios) de los pasos descritos arriba. Hay hasta blogs dedicados a recoger las cada vez más frecuentes retracciones (retirada de artículos publicados por problemas éticos o metodológicos) que ocurren en todo tipo de journals, incluidos los más prestigiosos. Podría argumentarse que la ciencia se termina autocorrigiendo pero, en un mundo ultraespecializado y de recursos limitados, el tiempo necesario para que ello ocurra implica unos costes cada vez más inasumibles.

En un artículo reciente en The New Yorker , Gary Marcus, profesor de psicología en la Universidad de Nueva York (EE.UU.), se hace eco de las propuestas que se publican en el último número de Perspectives on Psychological Science para reformar aquellos elementos que están favoreciendo que, primero, se desvirtúe el método científico y, segundo, se malgasten los escasos recursos en investigaciones no válidas. Las medidas que se plantean son las siguientes.

Reestructurar los incentivos a la ciencia. Por distintos motivos la profesión científica se ha convertido en una carrera en la que prima la velocidad, y no necesariamente la meticulosidad. Las becas, el conseguir un puesto fijo y el publicar, todo ello interrelacionado, dependen en última instancia de conseguir unos resultados llamativos y sorprendentes. Es difícil publicar un estudio que simplemente reproduce uno anterior, y es difícil conseguir un puesto en una universidad o un centro de investigación sin tener publicaciones en journals con un índice de impacto respetable. Toda esta presión hace que se termine recortando en metodología, con la única intención de conseguir la ansiada publicación sorprendente, que idealmente llame la atención de los medios. En vez de recompensar a los científicos por el número de publicaciones (lo que es una forma de recompensar los resultados rápidos y sin demasiado fundamento que terminan no siendo fiables), se les debería valorar en mayor medida por producir resultados sólidos y fiables, que otros hayan conseguido reproducir y ampliar

Animar igualmente a publicar los estudios que fallan que los que tienen éxito. A pesar de la evidente utilidad de publicar lo que no ha funcionado, pocos journals publican resultados fallidos y pocas becas se dan si no se aportan resultados positivos. Sin el registro fiel de los intentos bien fundamentados y registrados que han fallado, la visión de la ciencia se ve distorsionada, como la memoria de un jugador que sólo recuerde las veces que ganó. Bien fundamentados y registrados implica también una mayor claridad y precisión a la hora de explicar la metodología empleada.

Asumir que ningún estudio aislado prueba nada. Sin una replicación independiente todos los estudios deberían ser considerados preliminares. En esto tanto la profesión científica como los medios son cómplices: hay una tendencia a publicitar con gran aparato cada nuevo resultado como si se hubiese probado algo, pero la mayoría de “nuevos estudios” son simplemente indiciarios de una posibilidad, no de una conclusión. Es necesario formar a los científicos, a los periodistas y a los responsables de la política científica en la paciencia.

Promover la realización de meta-análisis. Esta técnica combina los resultados de muchos laboratorios diferentes, lo que permite a los investigadores detectar efectos leves pero consistentes que son difíciles de ver es estudios individuales y descartar aquellos más espectaculares que han ocurrido por accidente. Las revisiones meta-analíticas de la colaboración Cochrane se han convertido en una pieza clave de la medicina basada en la evidencia, y hay iniciativas como el Open Science Framework que están contribuyendo a que los meta-análisis se conviertan en algo sistemático en todas las áreas de la ciencia.

Crear un código ético. De la misma forma que existen códigos deontológicos en la práctica médica, en la abogacía o en la ingeniería, la práctica científica debería tener el suyo propio. Un joven científico debería conocer lo que se espera de él éticamente, al igual que intelectualmente.

Crear una policía científica. Hay cosas que son demasiado buenas para ser ciertas, como en las finanzas. Una nueva especie de detective es necesaria, cuya principal arma sea la estadística y su método el meta-análisis. Quizás pudiera ser necesaria una institución que los acogiese.

La Ciencia con mayúsculas es acumulativa, no una lista de resultados divertidos; conforme se profundiza las ideas no válidas terminan desmoronándose. Incluso si no cambiásemos nada, terminaríamos consiguiendo un mayor conocimiento del universo en el que vivimos. Pero no hay duda de que llegaríamos antes si depurásemos primero nuestra forma de actuar.

Y tú, ¿qué opinas?

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Francisco Camiña Ceballos.

Algunos comentarios…

1. Reestructurar los incentivos a la ciencia: A día de hoy, más que el número de publicaciones, el indice H está siendo muy utilizado en el proceso de elección de investigadores. De toda formas calidad vs cantidad es un debate que lleva sobre la mesa mucho mucho tiempo. Además, los distintos campos exigen distintos tiempos para poder cosechar resultados y conclusiones dignas de ser publicadas en revistas del primer tercio. Me gustaría añadir que también es muy importante el número de firmantes de un trabajo y el orden de estos. No es lo mismo que dos investigadores publiquen en una revista estrella, o de mucho impacto, a que lo hagan un compendio de 20 o 30 investigadores.

2. Publicar estudios negativos. Esta medida ha sido propuesta en muchas ocasiones por distintas personas de distintos campos. De todas formas la decisión de publicar estos resultados tienen que tomarla las revistas de investigación. El ranking de las revistas por indice de impacto dificulta la publicación de estos artículos, ya que presumiblemente estos serían poco citados, por lo que a las revistas no les interesa.

Podríamos estar hablando de este tema horas y horas… Se deja el autor cosas en el tintero. Como que se valora más a los investigadores que trabajan en «humana» que los que trabajan en otros campos; se valora más a los investigadores que siguen las modas del momento (secuenciación del DNA frente a otras aproximaciones, por ejemplo); se valor más a lo investigadores que trabajan en aplicada que los que trabajan en básica… Como dice mi maestro la ciencia es human condition… lo único que podemos hacer los investigadores es trabajar mucho y muy fuerte, y que la suerte o la buena estrella nos pille en el laboratorio, sobre un manuscrito, o pensando en esa hipótesis que se nos resiste…

ununcuadio

Muy interesante lo planteado…

No sé hasta qué punto serían viables los puntos señalados, porque al final, no se trata únicamente de la ciencia, sino que esta se interrelaciona con política: ¿cuántas medidas aprobadas se cumplen para detener el cambio climático? ¿Son estas medidas suficientes para que tengan un resultado positivo? Preguntas que se pueden hacer en campos como la biodiversidad: los científicos del GBIF no están de acuerdo con lo que finalmente deciden los políticos. Hay una especie de obstinada resolución de que los expertos exageran.

Por detrás de muchos experimentos científicos hay ideologías y movimientos políticos que los financian, con lo que si normalmente cuesta asumir los errores (desde un punto de vista meramente individual), ¿cómo publicar meta-análisis que contradicen abiertamente lo publicado anteriormente? ¿Dónde queda la financiación invertida, cómo solucionar los problemas que se hayan podido causar?

JC García-Bayonas M. (@2qblog)

Cuando he visto el esquema me he preguntado ¿qué raro que no se hable en el esquema de que los informes tienen que ser verificados por organismos independientes? y al leer las 6 propuestas me doy cuenta que se centran en esa parte del método.

Estoy de acuerdo con todas, en la medida de lo que recuerdo de mis años universitarios.

Si que quiero hacer una aportación: recuerdo cuando estaba terminando el trabajo fin de carrera los debates que mantuve con mis directores de tesina sobre porque no poníamos donde nos habíamos estrellado, que dificultades habíamos encontrado, como las habíamos superado… Me imagino que muchos de los que se dedican a la investigación saben de lo que estoy hablando. Al leer mi tesina terminada, no solo pensaba que de alguna forma había desvirtuado la investigación, también pensaba que no reflejaba la cantidad de horas y esfuerzo que había dedicado en el laboratorio.

Y para finalizar: también opino que en el campo educativo muchas veces pasan cosas parecidas a las que tú redactas. Conozco casos de profesores que hacen grandes investigaciones docentes y luego la Administración Educativa solo reconoce aquellos trabajos que se adaptan a unos estándares que distan mucho de ser los más adecuados. Al final «muchos de los trabajos de investigación docente (proyectos de innovación…) no son para los alumnos, son para que la Administración te los reconozca (puntúe)».

Un saludo.

PDT. Seguramente usaré el texto de alguna forma cuando explique el método científico (desde hace unos dos años debatimos/explico textos donde se habla de la «retirada de artículos publicados en journals científicos por problemas éticos o metodológicos»)

6 propuestas para mejorar la forma en que se hace ciencia. | Ideas para aplicar en el aula | Scoop.it

[…] Cuando pensamos en el método científico solemos tener en mente algo parecido al esquema que abre esta anotación. Sin embargo, a la hora de la verdad, con tantos científicos trabajando en el mundo, … […]

Francisco Sarabia

Muchas de las cuestiones propuestas me parecen muy interesantes, aunque algunas son inaplicables y otras muy discutibles. El principal problema es que se quiere meter toda la ciencia en el mismo saco. Y no puede ser. En ciencias sociales, sanitarias, experimentales, de ingeniería o físicas, los tempos de investigación no son los mismos, ni la generalización de los resultados. Tampoco son iguales los conceptos de «veracidad», «estudios que fallan», etc. Como se ha dicho anteriormente, sobre esto hay mucho de qué hablar.

Pero estoy absolutamente de acuerdo en tres puntos: reestructurar los incentivos (ahora tienen un enfoque gerontocrático: los más viejos -que suelen ser los más inmovilistas- tienen más y mejor que los nuevos valores emergentes), que exista una política científica coherente (en España creo que hay cinco temas que precisarían un enfoque de estado y uno de ellos es la ciencia) y más formación en ética científica.

6 propuestas para mejorar la forma en que se hace ciencia

[…] 6 propuestas para mejorar la forma en que se hace ciencia […]

José Luis Moreno

Tema interesante y controvertido que daría para hablar largo y tendido. En cualquier caso, coincido en la necesidad de la mayor parte de las propuestas aunque, en el estado actual de la sociedad, será difícil su consecución. Al final, hasta los científicos son seres humanos y el mantener un estatus o, sencillamente, su puesto de trabajo evita que haya cambios relevantes. A pesar de todo, ya hay al menos dos (que yo conozca) revistas dedicadas a publicar estudios con resultados negativos: el «Journal of articles in support of the null hypothesis» para todas las áreas de la psicología, y el «Journal of negative results in biomedicine» . Con tu permiso te citaré porque estoy escribiendo sobre este tema y me ha parecido muy interesante esta aportación. Un saludo

Idebenone

En algunos casos, la literatura en sí misma, puede servir como una fuente de datos . Esto sucede en el caso de la paleontología, por ejemplo, dónde muchas investigaciones en los últimos cientos de años han consistido en la publicación de descripciones de la ubicación de fósiles, incluidas las especies y géneros que se encuentran en las diferentes capas de rocas. En 1982, John Sepkoski Jr. publicó una recopilación de datos del momento en que una especie particular de fósiles marinos que aparecieron primero en el registro de la roca desaparecerían posteriormente. Estos datos provenían de miles de informes publicados ( Sepkoski, 1982 ). En varios trabajos anteriores, Sepkoski analizó estos datos recopilados y basándose en ese análisis, desarrolló nuevas ideas sobre la diversidad taxonómica en el curso del tiempo (por ejemplo, Sepkoski, 1979 ). En 1984, Sepkoski y su colega David Raup publicaron un trabajo controvertido sobre la incidencia regular y aparente de eventos de extinción masiva en diferentes épocas ( Raup & Sepkoski, 1984 ), basándose totalmente en la recopilación de datos publicados en la literatura. Este tipo de análisis, frecuentemente llamado meta-análisis, no se puede hacer sin un archivo de investigación confiable que ofrece la literatura científica. El meta-análisis es especialmente útil en los campos de la medicina y de la ciencia climática, donde los resultados de los estudios con métodos diferentes se pueden combinar para dar resultados más sólidos.

Tuits para el fin de semana (S03E03) | Docencia Calvià

[…] exige una disciplina tan estricta como cualquier otra práctica. Por eso es interesante el post “6 propuestas para mejorar la forma en que se hace ciencia”, publicado por César Tomé (editor de Mapping Ignorance) en el Cuaderno de Cultura Científica de […]

Lo Mejor de la Semana (30 de diciembre-5 de enero) | Hablando de Ciencia | Artículos

[…] Experientia Docet, 6 propuestas para mejorar la forma en que se hace ciencia, ¿y tú qué […]

La clave de la memoria que no lo era « Cuaderno de Cultura Científica

[…] semana pasada describíamos 6 propuestas para mejorar la forma en que se hace ciencia. Una de ellas era asumir que ningún estudio aislado prueba nada. Ni tampoco una serie de ellos. Ni […]

Arnoldo Alarcón Orozco

Realizar la investigación de cualquier simple asunto, convierte al investigador en un ser ordenado si en verdad desea exito. Por lo anterior espero que se añada un análisis más profundo sobre cada uno de los pasos, en muchas ocasiones educandos y educadores hacemos caso omiso al orden, a la recolección de datos y a la importancia del análisis de lo que no se logra o el error cometido en un procedimiento; dentro de ellos se podría encontrar algo más interesante que la simple hipótesis comprobada. Gracias por tan explendorosa oportunidad.

Antonio Altamira de Asís

César, lo único que necesita mejorarse en la forma en que se hace ciencia son: una mayor competencia técnica del científico y su compromiso ético.

Todo lo demás viene rodado. Bajo ambos «axiomas», el científico: será meticuloso, explicará en detalle el método científico utilizado, publicará los estudios fallidos, etc. Pero sin ética y sin competencia, de nada sirve una mejora en la política científica: al fin y al cabo, el mal científico ¿va a publicar un estudio fallido que ha costado millones de euros pero que ha fallado desde su propio diseño por pura incompetencia científica?.

#método sobradamente honesto « Cuaderno de Cultura Científica

[…] tramposos. No dudo que en este terreno haya un camino por recorrer (ya nos referimos aquí hace unas semanas a cómo mejorar la forma en que se hace ciencia), pero de ninguna manera hay que […]

Entrevista a César Tomé (Experientia Docet): “Ninguna iglesia o religión tiene magisterio sobre nada” | Muera la Inteligencia

[…] Ojo, matización, no me verás nunca hablar sobre un método científico. Niego la mayor: no existe un solo método científico. Lo que la gente suele citar como método científico, que es el método lógico-deductivo, es […]

6 propuestas para mejorar la forma en que se ha…

[…] Imagen: Wikimedia Commons Cuando pensamos en el método científico solemos tener en mente algo parecido al esquema que abre esta anotación. Sin embargo, a la hora de la verdad, con tantos científicos trabajando en el mundo, con, […]