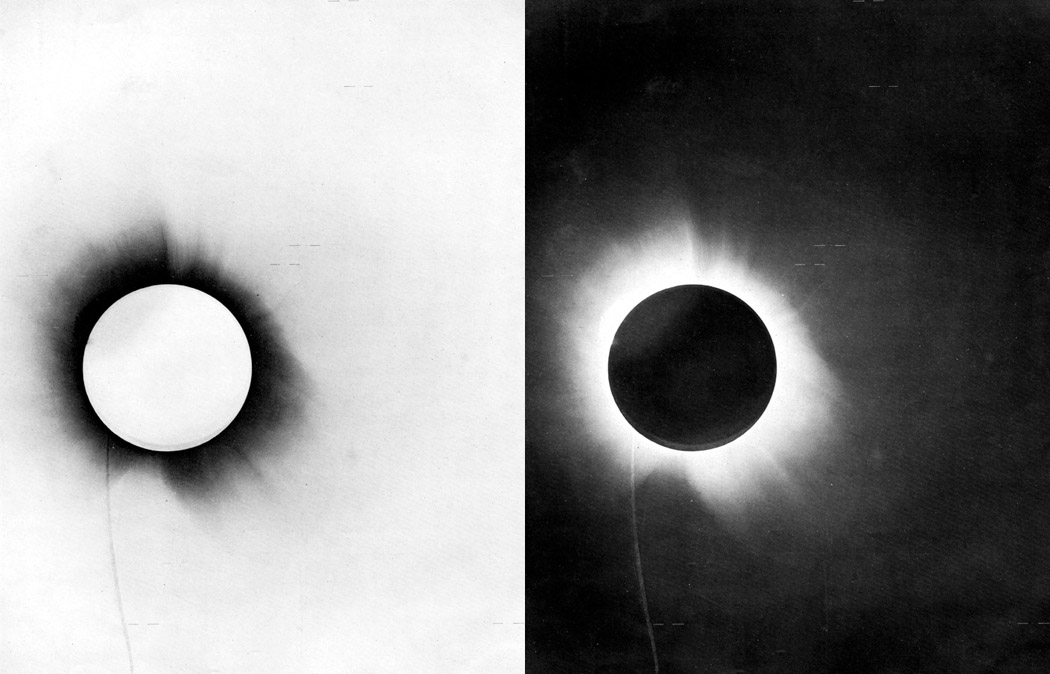

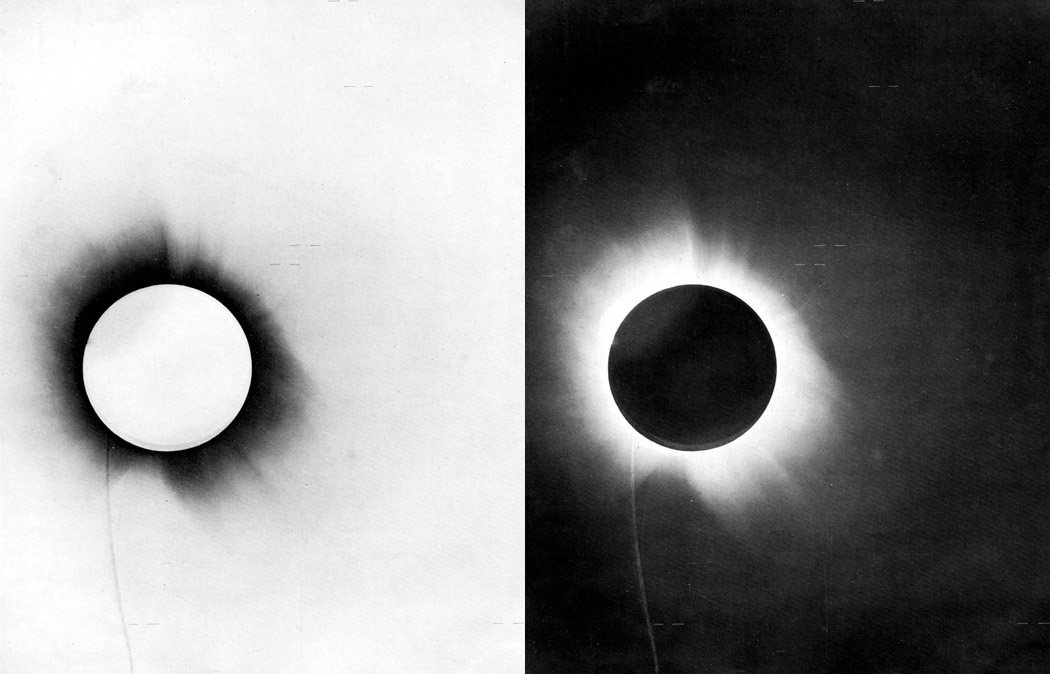

Es conocido el hecho de que Albert Einstein se hizo mundialmente famoso tras la medición por parte de Arthur Eddington el 29 de mayo de 1919 de la desviación que sufría la luz al pasar cerca de un objeto masivo, en este caso el Sol. En muchos lugares veremos recogido que este efecto era una predicción de la teoría general de la relatividad de 1916, y esto, para sorpresa de alguno, ya no es del todo correcto.

La predicción de que la luz sufre una desviación al pasar cerca de un objeto masivo está presente en la mecánica newtoniana. Tanto es así que tanto Henry Cavendish en 1784 (en un manuscrito que, fiel a su costumbre, no publicó) como Johan Georg von Soldner realizaron cálculos de la magnitud de esa desviación. El manuscrito de von Soldner [1], titulado “Sobre la desviación de un rayo de luz de su movimiento rectilíneo por la atracción de un cuerpo celeste del que pasa cerca”, escrito en 1801 y publicado en 1804, contenía los resultados de éste.

En 1911 Einstein publicaba el artículo “Sobre la influencia de la gravedad en la propagación de la luz” [2], ampliación de uno de 1908, en el que obtenía, atención, los valores de von Soldner pero, eso sí, basándose únicamente en el principio de equivalencia. Tal era la coincidencia numérica que Philipp Lénárd tuvo base para acusar después a Einstein de plagio.

Avanzada la teoría general de la relatividad, Einstein se dio cuenta de algunos errores, y corrigió sus cálculos en 1915 obteniendo los datos (la suma de los efectos clásicos y de la dilatación temporal gravitacional) que después Eddington daría por confirmados en 1919.

En su artículo de 1911 Einstein proporcionaba una posibilidad de comprobar experimentalmente sus teorías. De hecho, Einstein asumía que una medición de la desviación de la luz a su paso por las cercanías del Sol probaría que su hipótesis era correcta y que Newton fallaba. A hacer la observación se avino Erwin Finlay-Freundlich, del Observatorio de Berlín. Finlay-Freundlich organizó una expedición financiada por Gustav Krupp von Bohlen und Halbach para observar el eclipse total de Sol del 21 de agosto de 1914 desde la península de Crimea. Pero, hete aquí, que el archiduque Franz Ferdinand fue asesinado en Sarajevo el 28 de junio de 1914; la Primera Guerra Mundial comenzaba exactamente un mes más tarde. Finlay-Freundlich, en ruta hacia Crimea, fue hecho prisionero.

La siguiente oportunidad de medición fue la que aprovechó Eddington en 1919, con los valores teóricos ya corregidos y la teoría general de la relatividad ya publicada en 1916. Sin embargo, y aunque las observaciones se repitieron varias veces (notablemente en 1922 y 1953), hasta que no se pudo medir en radio frecuencia, ya en los años 60, la incertidumbre de las mediciones no se redujo lo suficiente como para confirmar que la desviación se correspondía con lo predicho por la teoría general de la relatividad y no la mitad de ese valor, lo predicho por Newton.

Historia ficción y falsabilidad

Imaginemos ahora, por un momento, que la guerra no hubiese estallado cuando lo hizo y que Finlay-Freundlich hubiera podido realizar su medición. Y que si la teoría general de la relatividad dice que debía haber obtenido “2”, hubiese medido “1,6”. Ponte en situación: estás en 1914, antes de las correcciones de Einstein de 1915. ¿Cómo se hubieran recibido esos datos? ¿Una confirmación de Einstein?¿Una disconfirmación (falsación) de Newton? ¿Ninguno de los anteriores?¿A gusto del consumidor? Y ¿en qué momento se habría producido la confirmación/disconfirmación definitiva?¿En 1919?¿En 1922?¿En los años 60?

En la anotación titulada “Provisional y perfectible” [Pyp], hablábamos de los límites de los razonamientos confirmatorio (y la inexistencia de confirmaciones definitivas) y disconfirmatorio y de la existencia de hipótesis auxiliares no explícitas. Cuando decíamos que “Las teorías científicas no son falsables” nos basábamos precisamente en Pyp. Quizás sea interesante abundar algo en la cuestión.

Muchos comentaristas, tanto en la anotación, como en Twitter o en otras anotaciones en otros blogs escritas como reacción a la nuestra, parecen no ser conscientes de que cuando reiteran la posición de que una hipótesis científica es falsable, realmente están diciendo mucho más de lo creen que están diciendo. Para empezar, afirman que existe una característica inherente a la hipótesis que, una vez “medida”, permite catalogar la hipótesis como verdadera o falsa. Por otra parte, está implícito en este planteamiento que esta característica es crítica, esto es, tras la medida la hipótesis sólo puede ser dos cosas, verdadera o falsa.

Si nos fijamos, la cuestión es que la disyunción “falsación/confirmación” asociada a la idea de que la falsabilidad es algo intrínseco a una hipótesis es algo muy bien delimitado desde el punto de vista lógico. Pero, tal y como vemos en el ejemplo, la no-confirmación no implica necesariamente falsación. En cualquier caso un modelo de alto nivel, como la física newtoniana en su momento, u hoy la teoría general de la relatividad, nunca se verá falsada por una sola observación (¿nos acordamos de los neutrinos superlumínicos y la hipótesis auxiliar de que “los cables están bien conectados”?), ni siquiera por un conjunto de observaciones.

La cuestión es: ¿cuántas pruebas son necesarias para rechazar una hipótesis?¿Y un modelo?

Hemos tratado un ejemplo físico. Si considerásemos un ejemplo médico, estaría aún más claro. A poco que reflexionemos veremos que la falsabilidad como criterio científico no se sostiene, la línea que delimita cuándo empezamos a tratar una hipótesis como no falsable está muy difuminada. Parafraseando a Sokal y Bricmont [3]: los modelos no se aceptan porque se demuestre que otros son falsos, sino que se aceptan por sus éxitos.

Referencias:

[1] J. G. von Soldner (1804) «Über die Ablenkung eines Lichtstrals von seiner geradlinigen Bewegung, durch die Attraktion eines Weltkörpers, an welchem er nahe vorbei geht», Berliner Astronomisches Jahrbuch, pp. 161-172

[2] A. Einstein (1911) «Einfluss der Schwerkraft auf die Ausbreitung des Lichtes», Annalen der Physik 35: 898–908.

[3] A. Sokal & J. Bricmont (1998). Fashionable Nonsense. Picador. Nueva York

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Iñaki

Por no buscar otro ejemplo, pongamos que la predicción de la desviación de la luz de Einstein era errónea. Pongamos que Einstein predice que va a salir 2 y que Fulanito hubiese medido 1000.

No sé si se ve por dónde voy. Aquí estás poniendo en juego una teoría con una sólida base y unas medidas que… andan por ahí: el posible error experimental o de cálculo es del orden de la discordancia de la predicción y la medida. Pero ¿y si se diera el caso que he expuesto más arriba?

Antonio (AKA «Un físico»)

Acabo de leer en el blog del Dr. Villatoro una entrada sobre el cambio climático. Parece que el mundo ha aceptado la hipótesis de que a mayor concentración de CO2, mayor temperatura media global. Esta hipótesis, ¿cómo podría demostrarse que es falsa?.

Los modelos del cambio climático recopilados por el IPCC no «se aceptan por sus éxitos»; sino porque existe una institución jerárquica (sometida a determinados intereses político-económicos) que los defiende en sus sucesivos informes.

ecosdelfuturo (@ecosdelfuturo)

Que si fuese cierto lo que dices para el IPCC, todavía quedaría la evidencia de la conexión paleoclimática entre CO2 y temperatura. Según la cita de Lakatos que pongo más abajo, falsarás la hipótesis cuando se empiecen acumular hechos que te obliguen a rehacer los modelos con demasiada frecuencia como para que empiece a parecer todo una chapuza o dejen de ser útiles.

César

Pues en ese caso lo más normal es que se buscase una hipótesis auxiliar como errónea, como en el caso de los neutrinos superlumínicos, antes de desechar a Newton. Lo siguiente sería repetir los experimentos para saber si se está ante una nueva física «más allá del modelo estándar» en 1914.

Cuando la discrepancia es tan grande está claro que, o bien hay un error de bulto en la medición en sentido amplio (hipótesis auxiliar), o se está ante un fenómeno nuevo que habrá que confirmar antes de dar nada por superado o ver la necesidad de una nueva hipótesis o modelo. Al hacer esto último estamos tratando a la teoría de Newton ( o la que sea que esté en cuestión) como falsable; si nos cerramos en lo primero, como no falsable.

Un caso como el que planteas está en la mecánica cuántica y el entrelazamiento. Fijémonos que empezando en las famosas discusiones durante la conferencia Solvay de 1927, y posteriormente, Einstein, Schrödinger y de Broglie, entre otros, estaban tratando de hecho la localidad como no falsable. Eso les llevó a aventurar la existencia de hipótesis auxiliares en forma de variables ocultas para justificar los datos experimentales.

Symploke

Un apunte de tipo histórico: los datos experimentales sobre etrelazamiento y no localidad son muy posteriores a las discusiones de la Solvay. Nadie supo cómo poder diseñar experimentos que falsaran la no separabilidad de la Mecánica Cuántica hasta los artículos de J. Bell (1964) – el artículo célebre de EPR anuncia el problema de incompletitud y Schrödinger, con su célebre gato, acuña el nombre de entrelazamiento (1935). Los primeros experientos sobre localidad y no separabilidad se realizan a medidos de los 70 y el más concluyente por Aspect 1982.

Creo que el experimento mental propuesto por Einstein, Podosky y Rosen en 1935 más que falsar ningún experimento, quería evidenciar el absurdo de tomar a la mecánica cuántica por una teoría completa, pues EPR ya sabían que las variables ocultas ya habían sido descartadas por el trabajo del matemático John von Neumann – claro que nadie se dio cuenta hasta D. Bohm que el teorema de von Neumann sólo prohibía las variables ocultas de tipo local aunque estas eran las úncas que interesaban a Einstein -para proteger la Teoría de la Relatividad-.

César

Gracias por el apunte. Hemos tratado precisamente esa cuestión anteriormente en el Cuaderno con una serie de artículos: http://zientziakultura.com/2013/04/02/incompletitud-y-medida-en-fisica-cuantica-vi-la-onda-piloto/ (encontrarás, al gato, a Bell y demás en alguno de los artículos de la serie citados al final).

Me tengo que remitir a la literalidad de mi comentario: «empezando» explícitamente en ese momento, algunos físicos tratan algunas cuestiones, entre ellas la localidad, como no falsable, esto es, parten de la idea de base de que la localidad es una condición «sine qua non». El desarrollo de los «gedankenexperimenten» iniciados en las discusiones de 1927 fructificará en la expresión explícita del conflicto con la localidad de EPR.

Por otra parte en ningún momento digo que Einstein y compañía pretendiesen «falsar», sino que trataban como no falsable algunos aspectos de lo que consideraban debía ser la realidad. Estoy intentando ilustrar lo que digo en Pyp.

Desviación de la luz y falsabilidad

[…] Desviación de la luz y falsabilidad […]

ecosdelfuturo (@ecosdelfuturo)

Mi cita predilecta al respecto es ésta de Irme Lakatos que creo que resume muy bien el estado de cosas.

“Todas la teorías científicas son infalsables. Las que tomamos en serio son aquellas que llevan a líneas de investigación que progresan en las que unos pequeños cambios acomodan una franja extensa de observaciones pasadas y futuras. Y las que abandonamos son aquellas que llevan a teorías “degeneradas”, donde ésta es parcheada y re-parcheada a la misma velocidad con que entran los nuevos hechos. ”

Iñaki

Muy buena cita. Me la apunto.

symploke

El estado de las cosas avanzó y la respuesta al refinamiento falsacionista de Lakatos y su criterio de demarcación basado en los programas de investigación científica es que Lakatos afirmó que un programa de investigación científica puede pasar por fases degenerativas y luego volverse progresivo, por ejemplo el atomismo. Lakatos afirmó que sólo podemos juzgar sobre la racionalidad de un cambio científico cuando ha pasado mucho tiempo, por eso es tan racional mantenerse fiel a un programa degenerativo en la esperanza de que vengan mejores tiempos como cambiar a un programa que en ese momento es progresivo., por lo que la teoría de los programas de investigación no nos sirve como criterio de demarcación. Por eso Feyerabend llama a Lakatos «su amigo y camarada anarquista» pues en el fondo para Lakatos tambie «todo vale».

Larry Laudan propone que si se desea hablar de racionalidad en la forma en que los científicos cambian de teorías, hay que olvidarse de pensar que éstas progesan hacia la veradad y ser mas modestos pidiendoles que el criterio de elección se base en su capacidad para resolver problemas.

Symploke

Creo acertada la afirmación que haces sobre que las teorías científicas no son falsables. Permíteme, no obstante completarla y hacer una observación. La crítica a la teoría popperiana se puede resumir en tres cuestiones específicas:

1) Si los enunciados básicos son, al igual que las teorías, falibles, entonces ¿Por qué mantener un enunciado básico usado para falsar una teoría a costa de esta?

Popper ya había contemplado en su libro de 1934 (La lógica de la Investigación científica) el uso de hipótesis ad hoc, pero siempre y cuando el científico lo haga con espíritu crítico y sólo cuando el hacerlo lleve a una falsación potencial mayor de las teorías (esto es la llamada decisión metodológica)

2)Introducción de hipótesis ad hoc para falsar la teoría.

Popper nos dice que los científicos aceptan la refutación de teorías a partir de un enunciado básico,como el que expones en el ejemplo, sólo como una conjetura más, sujeta en si misma a falsación.

3)Tesis de Duhem-Quine: Las contradicciones en muchas ocasiones no aparecen solo en relación al cuerpo principal de la teoría sino en relación a las hipótesis auxiliares utilizadas para su contrastación.

Popper responde que admite que las teorías sólo se pueden falsar al completo «la falsación sólo afecta a sistemas teóricos al completo»

4)¿Podemos justificar los enunciados básicos- enunciados acerca de un evento observable- simplemente haciendo referencia a lo observado?

Popper: Aunque los enunciados básicos son contrastables a partir de experiencia/observación es necesario distinguir entre la justificación (lógica) y la aceptación ( que es algo personal, psicológico). La aceptación personal de los enunciados básicos por la experiencia no nos permite justificarlos de forma lógica, es más no hay justificación lógica de los enunciados básicos a partir de la experiencia.

José Luis Ferreira

«Para empezar, afirman que existe una característica inherente a la hipótesis que, una vez “medida”, permite catalogar la hipótesis como verdadera o falsa.»

Esta es la clave, me parece, y me parece que con esto nos podemos entender.

Inductivismo tradicional: Busquemos hechos que validen la hipótesis. Se valida por inferencia estadística (aumentando la probabilidad a posteriori si los datos son los predichos).

Falsabilidad tradicional: Busquemos hechos que refuten la hipótesis. Se invalida la hipótesis si se encuentra un hecho contradictorio con la predicción.

Tu posición parece ser que el introducir el error en la falsabilidad anula la validez de la idea tradicional. Mi posición es que podemos seguir hablando de falsabilidad, pero reconociendo esta posibilidad de error, de manera que viene a ser la otra cara del inductivismo (la refutación también es inductiva).

Falsabilidad como debe ser: Busquemos hechos que refuten la hipótesis. Se invalida por inferencia estadística (disminuyendo la probabilidad a posteriori si los datos no son los predichos).

Es mi tesis número 15 aquí:

http://todoloqueseaverdad.blogspot.com.es/2009/06/varias-tesis-sobre-las-teorias.html

César

Tu planteamiento es una aproximación mejor a la ciencia real que el falsacionismo como tal, en mi opinión. Pero, si lo continúas, verás que esa senda lleva a esos casos en los que ¿cuándo debe rechazarse una hipótesis?¿cuántas pruebas en contra se consideran suficientes?, y aquí podemos extraer ejemplos de la historia en los que hubo gente que se mantuvo en sus trece contra viento y marea (a pique de tratar a su hipótesis como no falsable), y tuvo razón en ello; y ejemplos de todo lo contrario.

Por ello, tal y como intento exponer en «Onus probandi», la falabilidad como criterio, ni siquiera como inferencia estadística, no se sostiene. Añado aquí que las hipótesis y sus modelos derivados no se suceden en el tiempo, como lleva implícita la idea de falsabilidad, sino que conviven y pueden llegar a complementarse.

Entre tú y yo: el falsacionismo es esgrimido por muchos porque es un digital (sí o no) y es fácil de entender; pero en absoluto es una descripción de la realidad del funcionamiento de la ciencia.

José Luis Ferreira

«¿cuándo debe rechazarse una hipótesis?¿cuántas pruebas en contra se consideran suficientes?»

Esas preguntas son las mismas que nos hacemos para aceptar una hipótesis. En ambos casos, aceptar o rechazar, se hace de manera provisional por la acumulación de datos y hasta que no haya otros nuevos. El no tener una línea nítida que marque el cuándo no implica que no acumulemos evidencias que en algún momento nos den una probabilidad que estimamos suficiente.

«podemos extraer ejemplos de la historia en los que hubo gente que se mantuvo en sus trece contra viento y marea»

Desde luego, de la práctica de cada científico podemos extraer esta especie de anarquismo metodológico que algunos propugnan. Pero la ciencia no es solo la práctica de cada científico cuando está él con sus intuiciones o sus locuras. Al final, saldrán adelante las teorías que se puedan encajar en el método científico, es decir aquellas que para las que sí se han ido acumulando evidencias que la verifiquen y se desecharán aquellas para las que se han encontrado evidencias que la hacen falsa.

Onus probandi y la definición de ciencia | Cuaderno de Cultura Científica

[…] hadesunita “es falsable” en el sentido que venimos criticando las dos últimas semanas (aquí y aquí). Entonces, ¿es el hadesunismo una explicación científica hasta que no se demuestre su falsedad? […]

Desviación de la luz y falsabilidad | &u…

[…] Es conocido el hecho de que Albert Einstein se hizo mundialmente famoso tras la medición por parte de Arthur Eddington el 29 de mayo de 1919 de la desviación que sufría la luz al pasar cerca de un … […]

Los triángulos de luz y el sintético a priori | Cuaderno de Cultura Científica

[…] era euclidiana? En absoluto. Tal y como apuntamos en Provisional y perfectible e ilustramos con Desviación de la luz y falsabilidad, ya no era posible: podía ocurrir perfectamente que los ángulos del próximo triángulo que […]

Jesús

Hola a todos.

Quiero apuntar dos ideas acerca de la tesis de la no falsabilidad de las teorías científicas, que parece que hace fortuna en este cuaderno de cultura científica.

La primera, que la tesis de la subdeterminación de las teorías por la evidencia (desde luego la variante extrema postulada por Quine en su memoria «Two dogmas of empiricism»), ha sido sometida en el ámbito de la filosofía de la ciencia a una crítica persuasiva durante los últimos 50 años. La crítica más rotunda fué dirigida por Grunbaum en su memoria «The Duhemian argument» del año 1962, en la que simple y llanamente afirma que quien quiera sostener tal tesis lo que debe hacer es demostrarla, y que mientras eso no ocurra, la hipótesis de la subdeterminación de las teorías científicas por la evidencia es pura especulación. Por el contrario, la tesis es fácilmente falsable recurriendo a la multitud de ejemplos que nos aporta la historia de la ciencia. Posteriormente, Donald Gillies, Larry Laudan o John Norton, por solo citar a pensadores razonablemente famosos, han abundado en la crítica de la tesis de la indeterminación. Así, a día de hoy, en el terreno de la filosofía de la ciencia, tal tesis se considera por muchos tan solo como un mito basado en la especulación.

En segundo lugar, y a partir de lo anterior, señalar que las teorías científicas sí son falsables; lo que ocurre, como ya señaló el propio Duhem, es que la falsabilidad de una teoría puede ser transitoriamente ambigua, pero al final del día, y bajo el peso de la evidencia en contra y de lo absurdo de intentar apuntalar continuamente y contra viento y marea un edificio en ruinas (=acomodación de las teorías), todas las teorías erróneas son falsables. Y, como ya indicaba, la historía de la ciencia nos aporta multitud de ejemplos de esto.

En todo este asunto, merece la pena leer el archiconocido texto “The Aim and Structure of Physical Theory” de Duhem , en particular sus capítulos 2 y 6, y si es posible en el original francés, ya que la traducción inglesa de 1954 omite algunos pasajes interesantes; seguro que más de uno se llevará una sorpresa descubriendo lo que realmente nos dijo este pensador acerca de la falsabilidad de las teorías científicas.

fernando

Alguien puede opinar sobre estos trabajos?

http://www.aias.us/documents/spanish/Documento150.pdf

http://www.aias.us/documents/spanish/Documento139.pdf

César Tomé

El primero es una memez. Y el segundo una majadería. En ambos casos luce por su ausencia una de las actitudes científicas básicas: el contraste experimental. Las teorías de Eisntein están archicontrastadas experimentalmente y, si no representan la descripción definitiva (suponiendo que ésta sea conseguible) de un aspecto importante del universo, sí constituyen la mejor aproximación disponible. Afirmar que los fotones tienen masa es entrar en contradicción no solo con Einstein, sino con todo el modelo estándar de partículas, además de lo que ello implicaría para la misma existencia del universo. No entraré en los aspectos formales que son, simplemente, patéticos.

fernando

Es verdaderamente «patetico» el enfoque matemático del aias.us/documents/spanish/Documento139.pdf ??

No tiene sentido lo que se plantea en la pagina 22 de este documento?

Algun matemático que pueda opinar sobre esto?

Entiendo que no se descarta la teoría de Eisntein, sino que se la corrige.

fernando

Hay muchas teorías alternativas a la Relatividad General, que buscan explicar geográficamente los fenómenos que hoy suponemos que son

causados por MATERIA y ENERGIA OSCURAS

fernando

Hay muchas teorías alternativas a la Relatividad General, que buscan explicar geometricamente los fenómenos que hoy suponemos que son

causados por MATERIA y ENERGIA OSCURAS

fernando

El mismo Eisntein considero estas ideas.

http://casanchi.com/ref/cartan_einstein01.pdf

Las ecuaciones de campo de la relatividad general – Cuaderno de Cultura Científica

[…] [3] La importancia de la cronología puede apreciarse en nuestro Desviación de la luz y falsabilidad […]

¿Cómo se ve realmente una estrella de neutrones? | Astrobites en español

[…] para las estrellas que no son particularmente densas (como nuestro Sol). Aún habrá una pequeña desviación de la luz que viaja cerca del Sol debido a la curvatura del espacio-tiempo en esa región (ver Figura 1). […]

¿Cómo se ve realmente una estrella de neutrones? – Tecnologias Online

[…] para las estrellas que no son particularmente densas (como nuestro Sol). Aún habrá una pequeña desviación de la luz que viaja cerca del Sol debido a la curvatura del espacio-tiempo en esa región (ver Figura 1). […]

How does a neutron star really look? – Be Viral

[…] is true even for stars that are not particularly dense (like our Sun). There will still be a small deviation of light that travels near the Sun due to the curvature of space-time in that region (see Figure 1). This […]

¿Cómo se ve realmente una estrella de neutrones? – Dinero Online

[…] para las estrellas que no son particularmente densas (como nuestro Sol). Aún habrá una pequeña desviación de la luz que viaja cerca del Sol debido a la curvatura del espacio-tiempo en esa región (ver Figura 1). […]

Comprobaciones experimentales de la relatividad general (y 2) — Cuaderno de Cultura Científica

[…] en otra parte hemos explicado que la predicción de que la luz sufre una desviación al pasar cerca de un objeto […]

Los astros no están donde los vemos

[…] un campo gravitatorio. Pensando en la luz como pequeños proyectiles, el científico alemán Johan Georg von Soldner obtuvo un primer resultado para el ángulo de desviación de luz estelar roz…. Y obtuvo unos sorprendentes 0.87 segundos de arco (es decir, un ángulo 372 414 veces menor que […]

Les étoiles ne sont pas là où on les voit – Le derniere heure -lederniereheure.com

[…] de Newton. Considérant la lumière comme de petites balles, le scientifique allemand Johan Georg von Soldner a obtenu un premier résultat sur l’angle de déviation de la lumière…. Et il a réalisé un arc étonnant de 0,87 seconde (soit un angle 372 414 fois plus petit qu’un […]