El interés por las máquinas inteligentes cruzó definitivamente el Atlántico durante la Segunda Guerra Mundial, con las necesidades militares de los Estados Unidos ante la incipiente Guerra Fría en un lugar destacado. Estados Unidos se convertiría en el líder absoluto en los aspectos teóricos de las máquinas inteligentes en la segunda mitad del siglo XX, con Japón como alumno aventajado en las realizaciones prácticas.

En una conferencia de una enorme repercusión organizada por John McCarthy en 1956, y propuesta entre otros por Claude Shannon, en el Dartmouth College apareció por primera vez el término “inteligencia artificial” para describir las distintas técnicas que podían conseguir que un ordenador actuase inteligentemente. Anecdóticamente, asistentes a la conferencia cuentan que se estuvo considerando seguir empleando el término de Wiener “cibernética” pero que fue rechazado para evitar introducir una dimensión filosófica al trabajo en ordenadores. El término de Wiener resurgiría en los años noventa como “ciberespacio” para referirse a un mundo que solo existe dentro de las redes de ordenadores.

Un colega de McCarthy, Marvin Minsky, definió la inteligencia artificial como “la ciencia de conseguir que las máquinas hagan cosas que requerirían inteligencia si las hiciesen humanos”. El término ha recibido muchas críticas, la más recurrente la de ser demasiado vago e impreciso. Sin embargo, se sigue empleando sesenta años después, quizás porque incorpora la vaguedad e imprecisión de los humanos cuando intentan comprender objetivamente qué es el comportamiento inteligente; algo que, paradójicamente, la mayoría de los humanos, incluidos niños, realizan sin aparente esfuerzo.

McCarthy desarrollaría el lenguaje de programación LISP (List Processing) que simplificaba la escritura de programas orientados a la solución de problemas simbólicos o lógicos, esto es, los no numéricos para los que se habían diseñado otros lenguajes de programación.

Durante años LISP fue el programa preferido por los investigadores en inteligencia artificial. De hecho, durante prácticamente toda la historia de la inteligencia artificial la investigación consistía básicamente en escribir programas en LISP para ordenadores normales, multitarea.

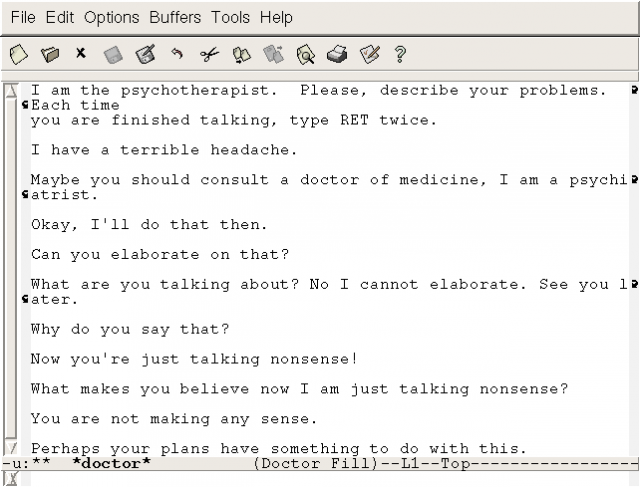

Un ejemplo famoso de estos programas fue ELIZA, un programa creado por Joseph Weizenbaum en el MIT entre 1964 y 1966, que era capaz de mantener una conversación con el usuario basada en preguntas y respuestas simulando la que mantendría con un psicoterapeuta.

También durante la mayor parte de su historia la inteligencia artificial ha tenido poca vinculación con la robótica, el arte de construir máquinas que replicasen actividades que habitualmente llevan a cabo las criaturas inteligentes. Ocasionalmente los investigadores en inteligencia artificial intentaron acoplar sus programas a micrófonos, altavoces, cámaras, motores eléctricos y cosas similares, pero estos proyectos fueron la excepción no la regla. Los investigadores argumentaban que que comprender las bases de la cognición ya les daba bastante trabajo.

En este divorcio original entre robótica e inteligencia artificial tuvo mucho que ver el criterio de DARPA (siglas en inglés de la agencia para proyectos avanzados de investigación del departamento de defensa de los Estados Unidos), que aportaba la mayor parte de la financiación para los proyectos de investigación en inteligencia artificial. DARPA, creada en 1958 por el presidente Eisenhower en 1958, apoyó desde el principio una definición restringida de inteligencia artificial.

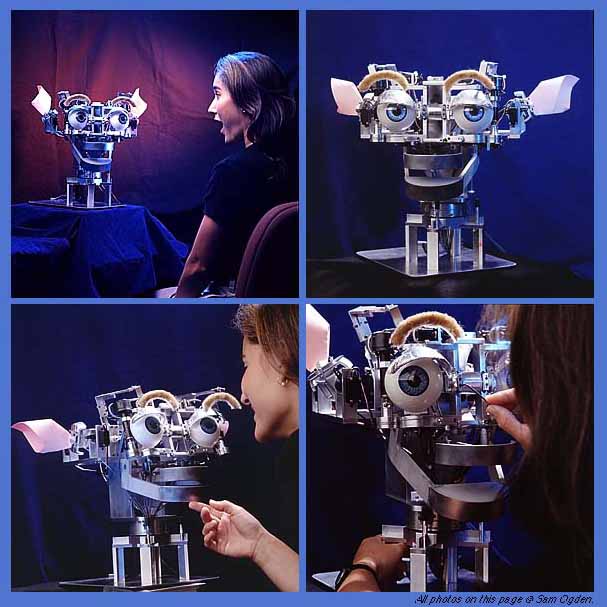

La situación cambió con el presupuesto de DARPA de 1985. Los fondos disponibles por la agencia se vieron recortados drásticamente, con lo que los investigadores se las tuvieron que ingeniar para conseguir financiación en otros lugares, lo que, indirectamente, les permitió ampliar sus horizontes de investigación. Como consecuencia desde mediados de los años ochenta la inteligencia artificial y la robótica se han venido aproximando cada vez más. A ello también ha contribuido la cada vez mayor disponibilidad de ordenadores, sistemas de procesamiento, sensores, motores y demás componentes cada vez más pequeños y eficientes y mucho más capaces de llevar las ideas de la inteligencia artificial a la práctica.

—-

En la serie Apparatus buscamos el origen y la evolución de instrumentos y técnicas que han marcado hitos en la historia de la ciencia.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Máquinas inteligentes (II): Inteligencia…

[…] El interés por las máquinas inteligentes cruzó definitivamente el Atlántico durante la Segunda Guerra Mundial, con las necesidades militares de los Estados Unidos ante la incipiente Guerra Fría en un lugar destacado. Estados Unidos se… […]

Máquinas inteligentes (II): Inteligencia…

[…] El interés por las máquinas inteligentes cruzó definitivamente el Atlántico durante la Segunda Guerra Mundial, con las necesidades militares de los Estados Unidos ante la incipiente Guerra Fría en un lugar destacado. […]

Aprendiendo de las máquinas — Cuaderno de Cultura Científica

[…] segunda mitad del siglo XX vio nacer la computación y el sueño de la inteligencia artificial —“la ciencia de conseguir que las máquinas hagan cosas que requerirían inteligencia si las […]

Aprendiendo de las máquinas – Fluceando

[…] segunda mitad del siglo XX vio nacer la computación y el sueño de la inteligencia artificial —“la ciencia de conseguir que las máquinas hagan cosas que requerirían […]

Aprendiendo de las máquinas – Enchufa2

[…] segunda mitad del siglo XX vio nacer la computación y el sueño de la inteligencia artificial—“la ciencia de conseguir que las máquinas hagan cosas que requerirían inteligencia si las […]

Qué es y qué no es inteligencia artificial — Cuaderno de Cultura Científica

[…] Máquinas inteligentes (II): Inteligencia artificial y robóticaEn el control de la inteligencia artificial nos jugamos el futuroEl séptimo ángel […]