La primera vez que leí, que yo recuerde, sobre falsos positivos fue en el interesante libro El hombre anumérico (Tusquets, 1990) del matemático y divulgador estadounidense John Allen Paulos. La situación que presentaba era la siguiente:

Supongamos que existe una prueba médica para detectar si una persona padece una cierta enfermedad (por ejemplo, cáncer), cuya fiabilidad es del 98%, y que esa enfermedad la sufren 1 de cada 200 personas. Un día nos hacemos dicha prueba y nos da positiva… ¿hasta qué punto nos debemos de preocupar? ¿qué probabilidad existe de que tengamos dicha enfermedad?

La cuestión es ciertamente importante, puesto que de la comprensión de la misma dependen tanto aspectos relacionados con la comunicación entre el equipo médico y el paciente, el primero debe trasmitir al paciente una gravedad en consonancia con la probabilidad mencionada, como aspectos médicos, es decir, la gestión médica de la situación.

Pero el problema planteado por el matemático en su libro, que no es otro que el de los falsos positivos, no solamente afecta a los análisis médicos, sino que aparece en diferentes situaciones de nuestra vida cotidiana, que van desde los tests de embarazo o los análisis de drogas, hasta los experimentos científicos.

Intentemos dar respuesta a la pregunta realizada por John Allen Paulos, es decir, en las condiciones planteadas cuál es la probabilidad de que una persona que ha dado positivo en la prueba médica para detectar cierta enfermedad la padezca realmente. Esto es lo que se conoce como probabilidad condicionada. No nos estamos preguntando cuál es la probabilidad de que una persona cualquiera tenga la enfermedad en cuestión, sino la probabilidad de que esté enferma sabiendo que ha dado positivo en el análisis (esta es la condición). Pero no vamos a adentrarnos aquí en la teoría de la probabilidad condicionada, ni en el Teorema de Bayes que permite calcularla, sino que vamos a realizar un razonamiento más intuitivo.

Antes de calcular esa probabilidad, vamos a explicar brevemente las dos informaciones que acompañan al problema. El primer dato es el número de personas que padecen dicha enfermedad, 1 de cada 200 personas. En general, cada enfermedad tendrá un porcentaje específico de personas que la sufren, de hecho muchas enfermedades tienen una incidencia más baja aún. Si hablamos de enfermedades raras, en Europa se suele considerar que son aquellas que hay menos de 1 enfermo por cada 2.000 habitantes, mientras que en EEUU se definen estas como aquellas que la padecen menos de 1 de cada 200.000 personas.

Si estamos realizando otro tipo de pruebas, habrá que considerar la correspondiente información sobre la incidencia, por ejemplo, en un estudio sobre tests de embarazo en Estados Unidos se mencionaba que “en cada momento hay un porcentaje de 5-6% de mujeres entre 15 y 45 años que están embarazadas [en EEUU]”.

El segundo dato que se ofrece es la fiabilidad de la prueba. ¿Qué significa esto? Que la fiabilidad sea del 98%, es decir, que haya una probabilidad del 98% de que “acierte” el análisis significa que si una persona padece la enfermedad tiene una probabilidad del 98% de que su prueba de positiva y un 2% de que de negativa, a pesar de que realmente está enferma. Y al contrario, si está sana, tiene una probabilidad del 2% de que su prueba de positiva y un 98% de que de negativa.

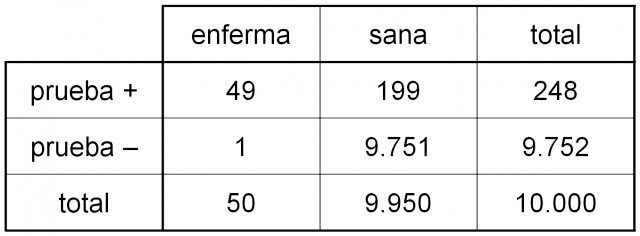

Calculemos ahora la probabilidad condicionada del problema inicial. Imaginemos que se realizan 10.000 pruebas médicas. Sabemos que la enfermedad la padecen 1 de cada 200 personas, entonces entro de ese grupo al que se le realizan los análisis habrá unas 50 personas que padezcan la enfermedad (1 de cada 200 personas) y 9.950 sanas.

Ahora, si tenemos en cuenta la fiabilidad de la prueba, que es del 98%, entonces:

a. De las 50 personas que padecen la enfermedad, la prueba les dará positiva a unas 49 (que es el 98% de 50) y dará negativa a 1 (el 2%).

b. De las 9.950 personas sanas, la prueba les dará positiva a unas 199 (que son el 2% de 9.950), al resto les dará negativa (el 98%).

En conclusión, dentro de ese grupo de 10.000 personas, hay 49 + 199 = 248 pruebas de detección de la enfermedad que han dado positivas. La mayoría de ellas, 199, son falsos positivos –es decir, la prueba es positiva, pero la persona no padece la enfermedad- y solo 49 son positivos reales. Luego,…

¡¡la probabilidad de tener realmente la enfermedad, habiendo dado positivo el análisis, es de 49/248, aproximadamente una probabilidad del 20%!!

Y por el contrario, la probabilidad de que sea un falso positivo es del 80%.

Alguien puede pensar que lo mismo pasará para los falsos negativos, es decir, una persona que sí tiene cáncer pero el test de la enfermedad es negativo. Sin embargo, aunque un falso negativo es posible, lo cierto es que es muy poco probable. De las cuentas que hemos realizado antes podemos extraer las siguientes conclusiones. De las 10.000 pruebas médicas, hay 1 que ha dado negativa pero que corresponde a una persona enferma (un falso negativo) y 9.751 negativas de personas sanas. Luego la probabilidad de un falso negativo es de 1/9.752, aproximadamente el 0,01%, muy pequeña.

Y eso para una enfermedad que tiene una tasa alta de afectados, un enfermo por cada 200 personas, pero si es una enfermedad con un menor número de casos, ese porcentaje baja mucho más. Por ejemplo, para una enfermedad tal que hay 1 caso por cada 1.000 habitantes, si el test sigue teniendo una fiabilidad del 98%, entonces habiendo dado positiva la prueba, solamente existe una probabilidad del 4% de tener dicha enfermedad (luego un 96% de que sea un falso positivo).

El problema de los falsos positivos es, sin ninguna duda, un tema importante como destacábamos al principio, que se agrava por el hecho de que lo elevado de su probabilidad va en contra de nuestra intuición. Existen estudios en los que se intenta ver el grado de comprensión de la anterior cuestión por parte del personal médico, pero que podemos extender claramente a toda la sociedad. Por ejemplo, en el artículo Interpretation by physicians of clinical laboratory results (N. Engl. J. Med., 1978), W. Casscells, A. Schoenberger y TB. Graboys preguntaron a un grupo de 60 personas, entre estudiantes y profesores de la Escuela de Medicina de la Universidad de Harvard, una cuestión similar a la planteada por J. A. Paulos y la mayoría de las personas pensaba que la respuesta –es decir, la probabilidad de tener la enfermedad siendo positiva la prueba– era, más o menos, la fiabilidad de la prueba (en el caso anterior, del 98%), sin embargo, como hemos visto es mucho menor (solo un 20% en el caso de una enfermedad con una incidencia de 1 enfermo por cada 200 personas, o incluso un 4% cuando hay 1 enfermo cada 1.000). Y algo similar comenta el sicólogo alemán Gerd Gigerenzer en su libro Calculated risks: how to know when numbers deceive you (Simon and Schuster, 2002).

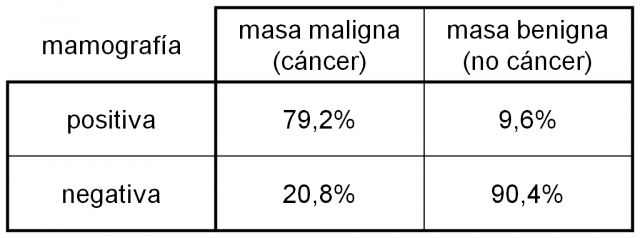

En el ejemplo que hemos mostrado la fiabilidad de la prueba es simétrica, es decir, es la misma sobre las personas que padecen la enfermedad que sobre las que no la padecen, pero esto no siempre es así. Este es el caso de uno de los ejemplos clásicos en la literatura sobre los falsos positivos, como es el caso de las mamografías para detectar cáncer de mama.

Además, este es un ejemplo que pone de manifiesto la importancia de conocer la probabilidad de un falso positivo. En un caso como el de la prueba de detección de drogas, como cocaína o cannabis, en saliva, si se produce un positivo, se realiza un sencillo análisis de sangre, que no es nada agresivo, para confirmar el consumo. Sin embargo, para el caso de una mamografía positiva, hay que acudir a una biopsia de la masa sospechosa, que es un procedimiento más complejo que un simple análisis de sangre.

Los datos para este ejemplo, la fiabilidad de las mamografías y la incidencia del cáncer de mama, los he tomado del artículo Probabilistic reasoning in clinical medicine: Problems and opportunities (D. M. Eddy, Judgment under uncertainty, capítulo 18, 1982). No son datos actuales y se refieren a los EEUU, pero nos sirven para comprender un poco mejor “cómo funcionan” los falsos positivos.

Imaginemos una mujer que va a su médico, o médica, de cabecera porque nota que tiene un bulto en uno de sus pechos, ante la duda el facultativo pide que le realicen una mamografía y finalmente esta es positiva (efectivamente se detecta una masa sospechosa). De nuevo, nos preguntamos cuál es la probabilidad de que la mujer tenga cáncer realmente, o de que sea un “falso positivo”.

La tabla siguiente nos muestra la fiabilidad de las mamografías en el diagnóstico de masas benignas y malignas. Además, la probabilidad de que esa masa sea maligna, es decir, de que la mujer tenga un cáncer de mama, se estimó en el artículo, que era de un 1%. La incidencia es de 1 de cada 100 mujeres.

De nuevo, para analizar la probabilidad de falsos positivos, supongamos que 10.000 mujeres con un bulto el pecho se realizan una mamografía. Como la incidencia del cáncer de mama es del 1%, entonces habrá unas 100 que tengan cáncer y 9.900 que no. Al realizar la mamografía tendremos que:

a. De las 100 mujeres que tienen cáncer de mama, a unas 79 (realmente son 79,2 según la tabla) la mamografía les da positiva, es decir, la masa en el pecho es sospechosa de malignidad (cáncer), mientras que para el resto, 21 mujeres, la prueba les da que es una masa benigna.

b. De las 9.900 mujeres que realmente no tienen cáncer de mama, la mamografía revelará que es una masa sospechosa de malignidad para unas 950 mujeres (el 9,6% de 9.900), y el resto, 8.949, se clasificarán como benignas.

En conclusión, de las 10.000 mamografías realizadas, 950 + 79 = 1.029 han reportado un resultado positivo, la masa sospechosa parece ser maligna según la mamografía, de las cuales 79 corresponden realmente a una masa maligna, a un cáncer de mama, luego la probabilidad de que una mujer tenga realmente cáncer de mama si la mamografía le ha dado positiva es de 79/1029, es decir, alrededor de un 7,7%. O equivalentemente, las mamografías tienen un porcentaje del 92,3% de falsos positivos.

Y ya puestos podemos calcular también la probabilidad de un falso negativo, en el caso de las mamografías, que es del orden del 2,3%.

Desde las matemáticas se estudian los falsos positivos, y en general, la probabilidad condicionada, sin embargo, es muy importante que en los ámbitos en los que se producen los mismos (medicina, derecho, ciencia, ingeniería, etc) se tenga un buen conocimiento de ellos para poder gestionar bien las implicaciones de su existencia y la probabilidad de los mismos.

En una de las siguientes entradas del Cuaderno de Cultura Científica mostraremos ejemplos de la presencia de la probabilidad condicionada en el derecho, en concreto hablaremos de la conocida como falacia del fiscal.

Bibliografía

1.- John Allen Paulos, El hombre anumérico, Tusquets, 1999.

2.- W. Casscells, A. Schoenberger y TB. Graboys, Interpretation by physicians of clinical laboratory results, N. Engl. J. Med. 229, 18, p. 999-1001, 1978.

3.- Gerd Gigerenzer, Calculated risks: how to know when numbers deceive you, Simon and Schuster, 2002.

4.- David M. Eddy, Probabilistic reasoning in clinical medicine: Problems and opportunities (capítulo 18), Judgment under uncertainty: heuristics and biases, Cambridge University Press, 1982.

5.- Breast Cancer Awareness Body Painting Project (BCABPP), comunidad en facebook

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

xa2

Muy interesante y… complicado de gestionar….

Siguiendo con el análisis, he hecho una simulación de «contra-análisis» a los casos de positivo y, si no me he equivocado, el falso positivo baja al 7,65 %. De todas formas, entiendo que no es aplicable a todos los casos (si repetimos la mamografía al grupo de positivos, se seguirá viendo lo mismo, si el cómo se toma la muestra es lo que es responsable del falso positivo no vale con practicar la prueba a la misma muestra, etc. etc.).

Siguiendo con el tema, esto también será válido para los casos de control anti-doping, y pensad en lo que supone una elevada probabilidad de falso positivo…

Enrique Rus

¿Se refiere a una segunda prueba similar?

Isidoro Martínez Vélez

Hola Raul, justo estoy terminando un artículo sobre «screening» de cáncer de mama mediante mamografía y tu post me ha resultado de gran ayuda.

Aún así me surgen un par de dudas con los 2 ejemplos con tablas que has puesto:

– Extrapolas directamente la proporción de 1 de 50 en falsos negativos al grupo de pacientes «sanos». ¿No habría que aplicar un margen de error?

– ¿Puede ser que te hayas liado un poco extrapolando «% tipo masas en positivos» al grupo de negativos en el cribado, al que en principio no se le detecta ninguna masa, ni maligna ni benigna (a este grupo de 9.900 mujeres lo sobrediagnosticas con una masa a cada una de ellas xDDD)?

¡Saludos!

Raúl Ibáñez

Querido Isidro,

Muchas gracias por tu mensaje. Te intento contestar aquí de forma breve.

i) Respecto al primer ejemplo, el cálculo de la probabilidad de falsos positivos, o negativos, este cálculo lo hemos realizado de forma intuitiva (obviamente en un grupo de 10.000 personas no necesariamente hay 50 enfermas y elk resto sanas, sería una esècie de «de media», y lo mismo ocurre con los resultados de la prueba), ya que el cálculo correcto sería mediante el Teorema de Bayes, aunque el resultado es ese mismo;

ii) en el segundo ejemplo no estoy identificando masas con positivos, tuve mucho cuidado en ello, y de hecho consulté con una persona del mundo de la sanidad para intentar no comenter ese tipo de fallos.

Muchas gracias por tus cuestiones, espero haber contestado a tus preguntas.

Un fuerte abrazo, Raúl.

Isidoro Martínez Vélez

Error mío, me lié con la incidencia y que presentas 10.000 personas con masas detectadas.

Lo que expones no es un «cribado» entre un grupo de personas para detectar cáncer, sino una «confirmación de diagnóstico» por presentar una masa sospechosa.

La mamografía no se usa para la confirmación, para eso está la biopsia. Normal que el número de falsos positivos salga tan alto… por eso no se usa la mamografía para esto, sino para diagnóstico precoz (aunque esto también está siendo evaluado)

Un abrazo.

Raúl Ibáñez

Querido Isidro, el razonamiento es válido para el cribado, aunque yo haya empezado el ejemplo con el médico de cabecera,…

Un abrazo, R

Isidoro Martínez Vélez

– El razonamiento por supuesto, las cifras no se corresponden de ninguna manera con el cribado mediante mamografía (que se realiza en pacientes supuestamente sanas) Y el procedimiento de diagnóstico que expones no es real (que no quiere decir que algún médico no lo haga)

– Si el médico de cabecera (o la propia mujer) encuentra un bulto por palpación (método no recomendado por su escasa fiabilidad) te hará y no en todos los casos una ecografía (o mamografía) antes de la biopsia (única forma de saber si es beningno o maligno) para saber con más exactitud el tamaño de la masa. Si presentas signos clínicos (como enrojecimiento, pezón invertido, etc.) vas a la biopsia de urgencia. Por ello es importante el diagnóstico precoz mediante cribado.

– Insisto en que la mamografía no es un método de diagnóstico del cáncer de mama, sino de sospecha inicial. Y ni los más críticos dan cifras de 92% de falsos positivos en cribado mamográfico de mujeres sin diagnóstico previo (entre 20-30% según sus estimaciones) Si hay diagnóstico previo, huelga la mamografía.

Un saludo,

Isidoro

tresko

No te esfuerces. No lo va a entender. Solo pretende jugar a los médicos. Encamina tu comentario a aquella mujer que pueda leer este artículo en desafortunada hora.

Falsos positivos, o la importancia de comprende…

[…] La primera vez que leí, que yo recuerde, sobre falsos positivos fue en el interesante libro El hombre anumérico (Tusquets, 1990) del matemático y divulgador estadounidense John Allen Paulos. […]

Putina

Sigo tus publicaciones frecuentemente.

De la importancia de cuantificar los falsos positivos en función de el verdadero número de enfermos, derivó lo que se conoce como valor predictivo positivo (probabilidad de habiendo resultado positiva una prueba, estar realmente enfermo, y sí, probabilidad condicionada).

En medicina a la fiabilidad de la prueba o capacidad de detectar un enfermo se le conoce como sensibilidad, mientras que a la capacidad de dar negativo ante un sano se la conoce como especificidad.

Es interesante que una prueba sea muy sensible para aumentar al máximo los diagnósticos, pero debe tenerse en cuenta el valor predictivo positivo para no alarmarse y saber cuál es el riesgo real de padecer la enfermedad aunque el test haya dado positivo.

No obstante en enfermedades en las que puede resultar traumático un falso positivo, se utiliza una prueba muy específica.

¿Debe el médico ayudarnos a comprender las probabilidades tras un resultado positivo? – Naukas

[…] Grima, profesora de Matemática Aplicada en la Universidad de Sevilla, o en este otro artículo Raúl Ibáñez, profesor del Departamento de Matemáticas de la Universidad del País […]

La probabilidad en el banquillo de los acusados | Matemoción | Cuaderno de Cultura Científica

[…] mi anterior entrada de la sección Matemoción del Cuaderno de Cultura Científica, Falsos positivos o la importancia de comprender la información, analizábamos el fenómeno de los falsos positivos en medicina (aunque son también importantes en […]

Jon

En realidad las cosas son un poco más complicadas, ya que habría que calcular la incidencia en la edad y sexo en la que se recomienda el cribado. Además, teniendo en cuenta que puede haber sesgos en la gente que acude al cribado (familiares con la enfermedad), el % de falsos positivos es menor. Y no digamos su es una prueba diagnóstica que se realiza por unos síntomas o unos antecedentes.

Los falsos positivos y la probabilidad – En radianes

[…] Falsos positivos, o la importancia de comprender la información […]

La ‘reverosis’ de Pablo – Cuaderno de Cultura Científica

[…] Como he comentado antes, de falsos positivos ya se ha hablado antes en este blog. Por ejemplo, en Falsos positivos, o la importancia de comprender la informaciónde Raúl Ibáñez, To screen or not to screen de Naia Pereda, o Errar es humano de Juan Ignacio […]

Fernando

La incidencia del 1% es del total de mujeres no de las mujeres que se encuentran un bulto.

¿Tiene relevancia el valor predictivo de las pruebas para la práctica clínica? Parte 3. – Por una Medicina Interna de Alto Valor

[…] Gestión de falsos positivos. […]